大大提升分類精度 | 殘差新特征學習方式——殘差持續學習(文末附下載鏈接)

本次介紹一種新的持續學習方法,稱為殘差持續學習(ResCL)。

該新方法可以防止多個任務的順序學習中的災難性遺忘現象,除了原始網絡之外,沒有任何源任務信息。通過將原始網絡的每一層和一個微調網絡線性地結合起來,ResCL重新測量網絡參數;因此,網絡的大小根本不會增加。為了將該方法應用于一般卷積神經網絡,還考慮了批歸一化層的影響。通過利用類殘差學習參數化和特殊的權重衰減,有效地控制了源性能與目標性能之間的權衡。該方法在各種持續學習場景中表現出最先進的性能。

一、背景及介紹

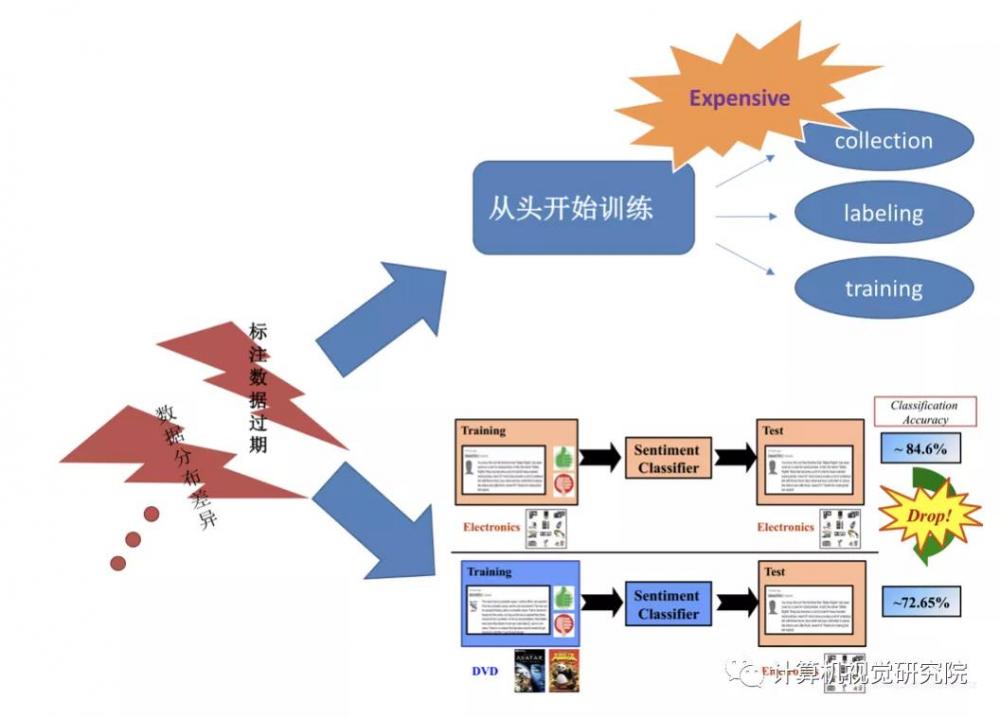

利用人工神經網絡進行深度學習是目前最強大的人工智能技術之一。它在計算機視覺等各種機器學習領域表現出最先進的性能。然而,需要大量的訓練數據和時間來訓練網絡結構變得復雜的深層網絡。為了緩解這一困難,如 Transfer learning微調,用于利用源任務知識和促進目標任務的訓練。

由于Transfer learning方法只考慮訓練過程中的目標任務性能,因此大部分源任務性能被稱為災難性遺忘現象的副作用而丟失。如果源任務和目標任務都需要高性能,這是一個嚴重的問題。應采用連續學習的方法來解決這一問題。

本次分享的技術,作者就是在保持源任務性能的同時,實現良好的目標任務性能。具體來說,專注于卷積神經網絡(CNNs)的圖像分類任務。此外,為這個問題強加了兩個實際條件。

首先,作者假設在目標任務訓練期間沒有源任務信息可用。在許多實際應用程序中,源數據往往太攀大,很難消化學習,無法處理或沒有public license。如果有,聯合訓練源數據和目標數據將是一個更好的解決方案。

此外,作者還假設不僅沒有源數據,而且也沒有包含源任務信息的任何其他形式。最近關于持續學習的研究沒有直接使用源數據,但它們經常引用有關源數據的部分信息,例如以生成對抗性網絡的形式或Fisher信息矩陣,這在某種程度上稀釋了持續學習的最初目的。

第二,網絡的規模不應增加。如果沒有這種條件,網絡可以擴展,同時保持整個原始網絡。這種網絡擴展方法在源任務和目標任務中都表現出良好的性能,但在實踐中很難將它們與深度神經網絡一起使用,因為隨著任務數量的增加,網絡的規模變得更大。

主要特點如下:

Residual-learning-like reparameterization allows continual learning, and a simple decay loss controls the trade-off between source and target performance;

No information about source tasks is needed, except the original source network;

The size of a network does not increase at all for inference (except last task-specific linear classifiers);

The proposed method can be applied to general CNNs including Batch Normalization (BN) (Ioffe and Szegedy 2015) layers in a natural way;

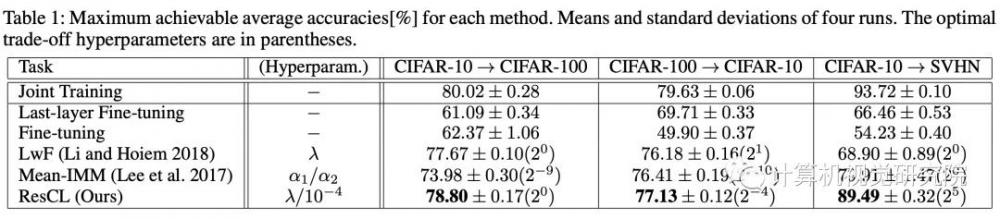

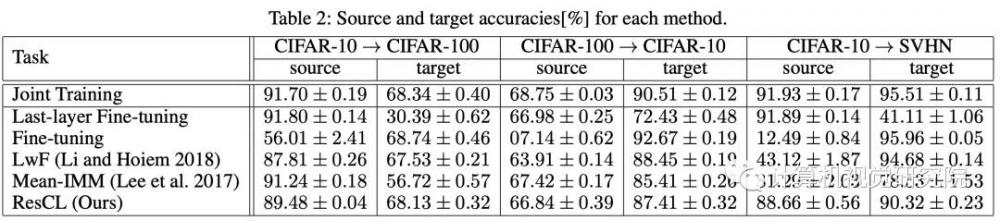

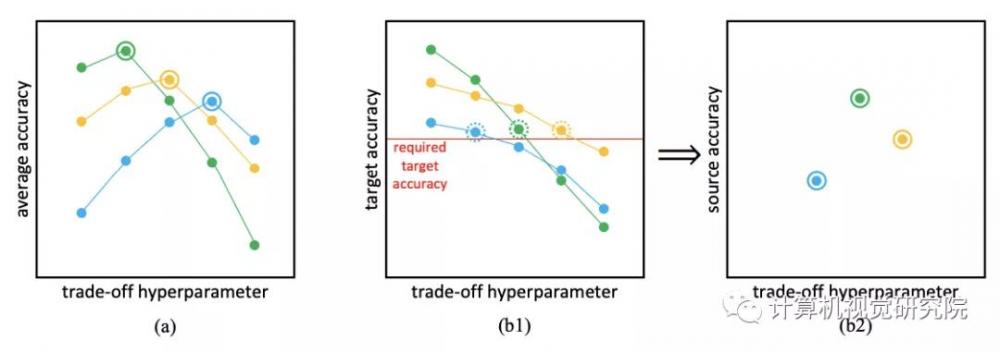

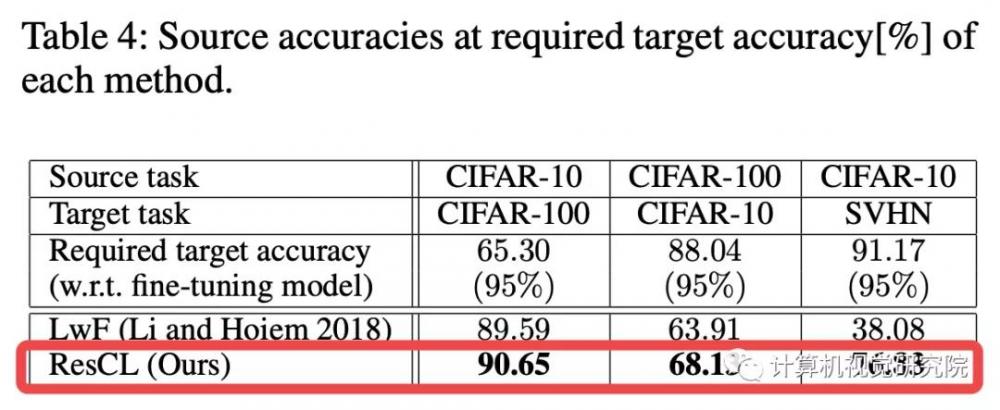

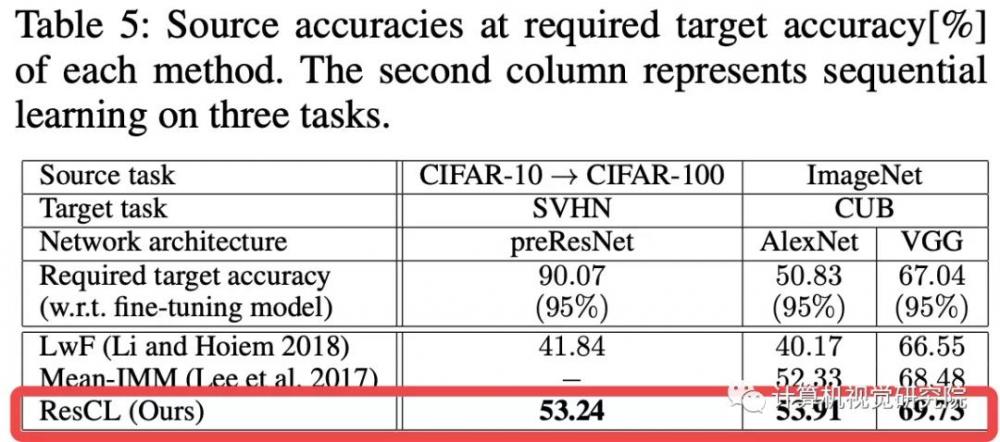

作者提出了兩種公平的措施來比較不同的連續學習方法,最大可達平均精度的理想測量和源精度在所需的目標精度的實際測量。

二、新方法

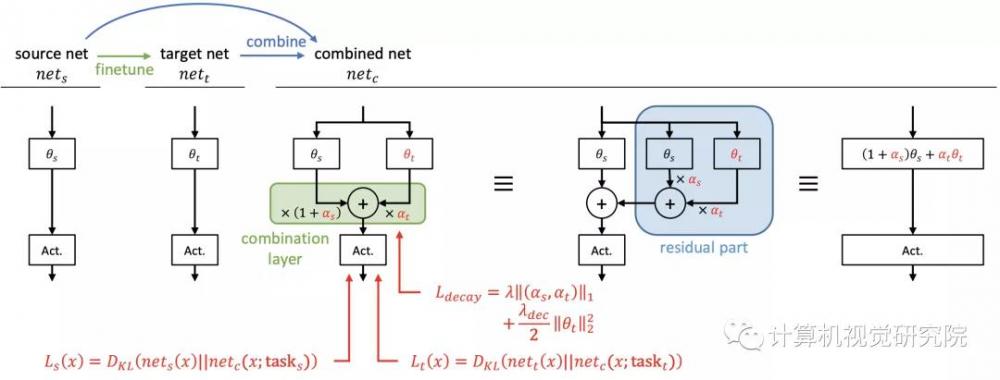

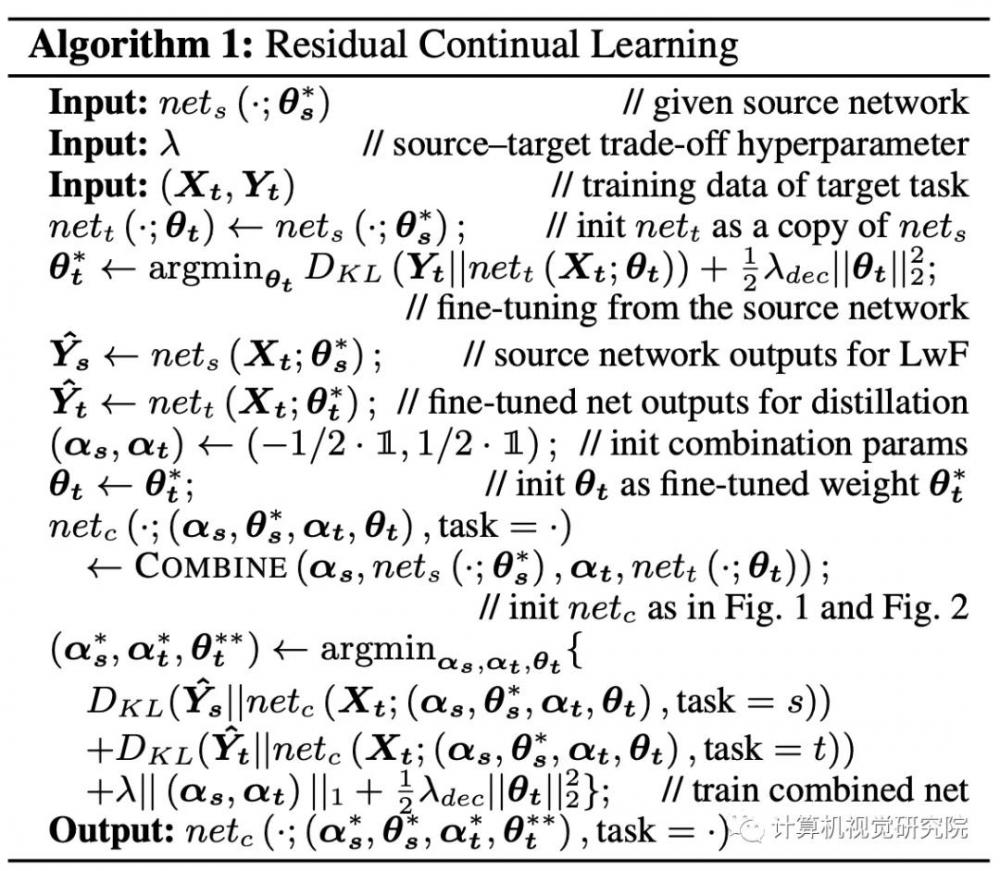

持續學習本質上是在兩個任務之間達到一個很好的中點。一個簡單的想法是將每一層源網絡和目標網絡線性地結合起來,以獲得它們之間的中間網絡,其中源網絡是對源任務進行訓練的原始網絡,目標網絡是從原始網絡中為目標任務進行微調的網絡。通過將它們結合起來,我們可以獲得位于源和目標任務解決方案之間的網絡。這個基本思想類似于IMM。

然而,線性組合網絡的性能沒有得到保證,因為神經網絡不是線性的或凸的。因此,在兩個網絡組合后,對組合網絡有一個額外的訓練階段,以確保它能夠正常工作。由于額外的訓練會損失源知識,所以在組合網絡中應該凍結原始權重。在下文中,經常把源網絡稱為原始網絡。

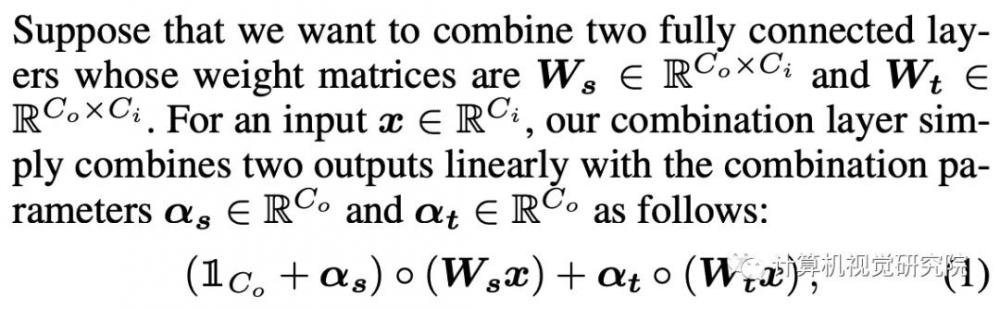

Linear Combination of Two Layers

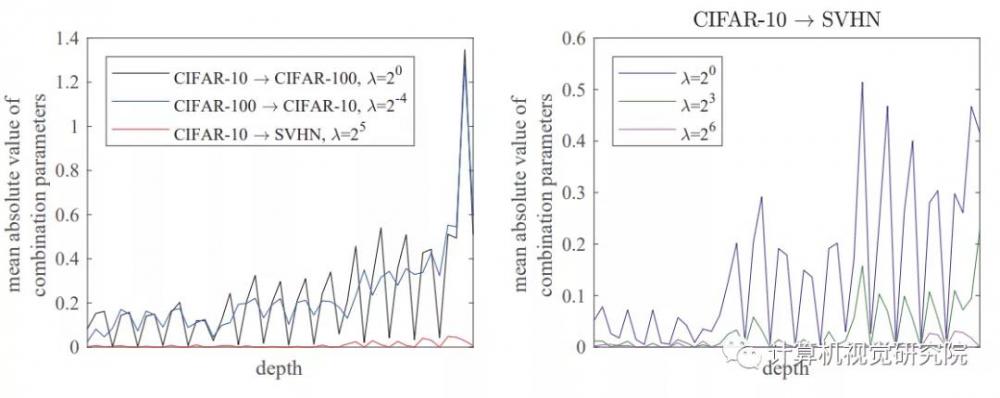

在ResCL框架中,Ws是源網絡的權重,Wt是從源網絡對目標任務進行微調的目標網絡的權重。此外,Wt還被訓練以細化其特征,以便與Ws很好地結合起來,而Ws是固定的,以防止災難性遺忘。

此外,還通過反向傳播來學習組合參數,以最優地混合兩個特征。因此,組合網絡中的可學習參數為Wt和α=(αs,αt)。人們可以很容易地發現,兩個全連接層和組合層可以等價地表示為一個全連接層,其權重是:

因為它們的線性,這就是為什么我們可以稱新方法為一種類型的重新參數化;因此,一旦訓練完成,網絡的大小就不會增加用于推理。任何非線性層,如sigmoid或ReLU,不應包括在組合中,如上圖和下圖所示,否則,這些層不能合并為一個層;然后,隨著任務數量的增加,網絡大小增加。

Train

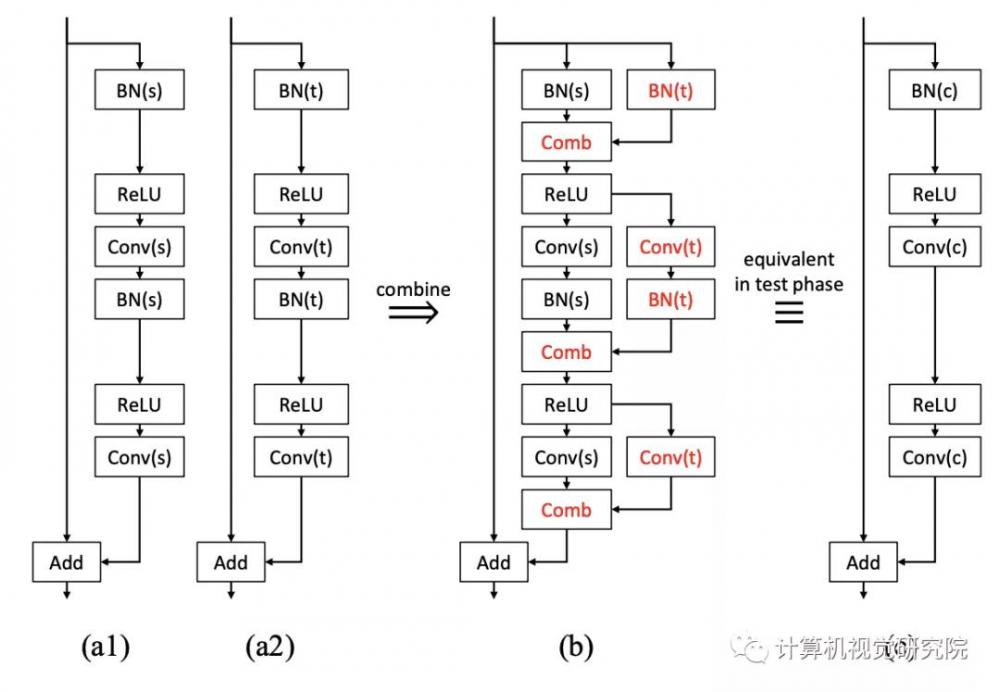

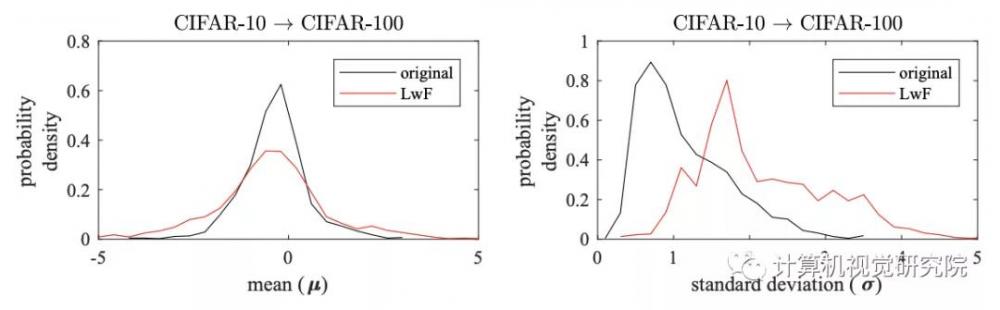

Convolution and Batch Normalization

新提出的方法可以自然地應用于BN層。我們不需要擔心分布的變化,因為每個子網都有自己的BN層來完成自己的任務。具體地,上圖中的原始BN層應在額外的訓練和測試階段使用其源任務的統計。否則,一些源知識就會丟失,因為聯合網絡在額外的訓練中無法看到和利用原始統計數據。具有組合層的兩個BN和兩個卷積層在訓練后也可以合并成一個等效卷積層,因為BN層在推理階段是確定性的線性層,卷積也是線性運算。

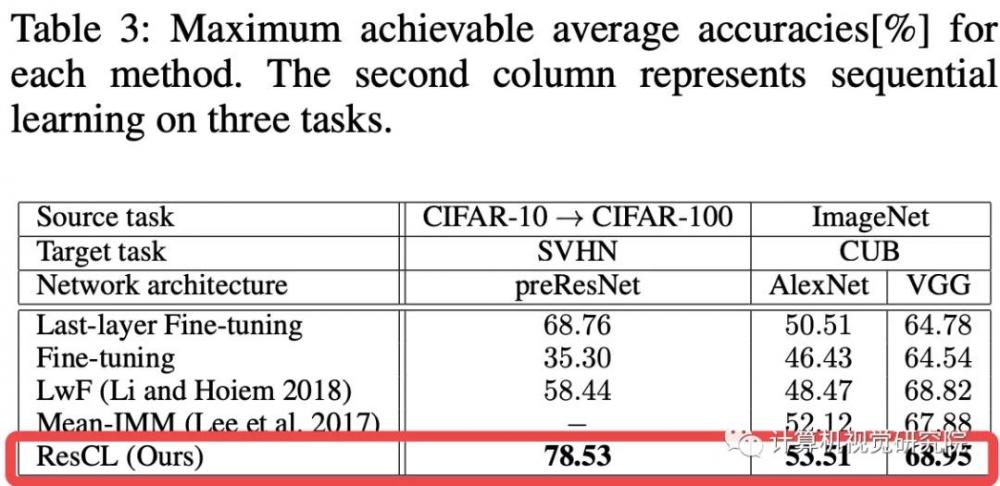

三、實驗

四、總結

提出了一種新的連續學習方法ResCL,它為圖像分類任務的連續學習提供了最先進的性能。它可以防止災難性的遺忘,即使源任務和目標任務有很大的不同。在實踐中可以使用ResCL,因為除了原始網絡之外,不需要關于源任務的信息,并且在推理階段網絡的大小不會增加。

此外,任何一般的CNN結構都可以采用,因為新提出的方法是用來處理卷積和BN層的。在本研究中,作者將任務的范圍限制在用CNN進行圖像分類的sequential learning。然而,ResCL方法可以自然地擴展到支持其他類型的神經網絡,例如遞歸神經網絡,因為它只是線性地結合了兩層的輸出。將ResCL方法應用于其他領域,以便今后的工作。

/End.

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。