ACL 2021 | 百度NLP開源語言與視覺一體的統一模態預訓練方法,登頂各類榜單

百度首創地提出了語言與視覺一體的預訓練方法 UNIMO,提供了一種新的統一模態學習范式,打破了文本、圖像和圖文對等數據間的邊界,讓機器可以像人一樣利用大規模異構模態數據,學習語言知識與視覺知識并相互增強,從而實現感知與認知一體的通用 AI 能力。

百度在 2021 年深度學習開發者峰會 WAVE SUMMIT 上開源了語言與視覺一體的預訓練模型 ERNIE-UNIMO,其核心方法 UNIMO 已經被 NLP 頂級會議 ACL 2021 主會正式錄用為 oral 長文。

在機器之心 7 月 31 日舉辦的 ACL 2021 論文分享會上,本文第一作者李偉詳細介紹了他們的這項研究成果,感興趣的同學可以點擊閱讀原文查看回顧視頻。

AI 系統能否像人一樣,使用一個統一的大腦模型,實現感知認知一體的通用能力?基于此出發點,百度提出的 UNIMO 試圖構建面向各種不同模態的統一預訓練模型。

論文地址:https://arxiv.org/abs/2012.15409

代碼地址:https://github.com/PaddlePaddle/ERNIE/tree/develop/ernie-unimo

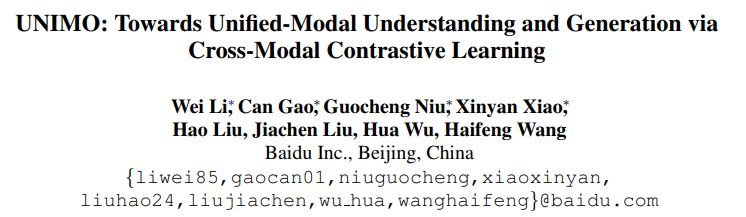

此方法首創的同時還能學習大量的文本、圖像、圖文對數據,通過跨模態對比學習,有效的讓語言知識與視覺知識進行統一表示和相互增強。UNIMO 在語言理解與生成、跨模態理解與生成,4 類場景共 13 個任務上超越主流的文本預訓練模型和跨模態預訓練模型,同時登頂視覺問答榜單 VQA、文本推理榜單 aNLI 等權威榜單,首次驗證了通過非平行的文本與圖像等單一模態數據,能夠讓語言知識與視覺知識相互增強。目前 UNIMO 已經逐步在百度的產品中落地應用。

UNIMO 方法介紹

大數據是深度學習取得成功的關鍵基礎之一。根據應用數據的模態不同,深度學習應用領域大體包括:在文本數據上進行自然語言處理,在視覺數據上進行視覺應用,在圖文數據上進行跨模態應用。顯然,人類大腦對各種模態數據的學習并非獨立的,比如,人類大腦在看到圖片之后能夠自動聯想到相關的語言知識,反之亦然。對各種模態數據的融會貫通,使得人類能夠充分學習各類語言、視覺、語音知識并相互增強,通過統一的模型展現出強大的智能水平。那么,基于深度學習的 AI 系統是否也能像人一樣同時學習異構模態數據呢?如果能夠實現,無疑將進一步打開深度學習對大規模數據利用的邊界,從而進一步提升 AI 系統的感知與認知一體的通用 AI 能力。

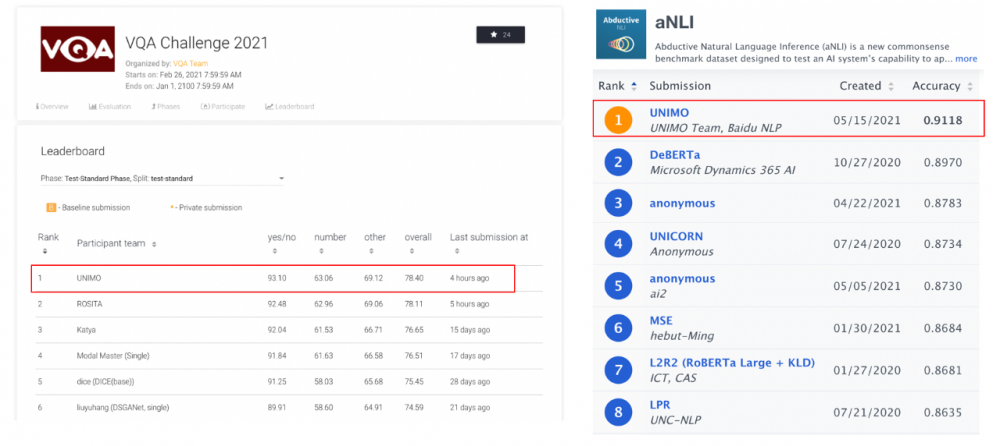

為此,百度提出面向異構模態數據的統一預訓練方法 UNIMO,同時使用文本、圖像和圖文對數據進行訓練,學習文本和圖像的統一語義表示,從而具備同時處理多種單一模態和跨模態下游任務的能力。UNIMO 的核心模塊是一個 Transformer 網絡,在具體訓練過程中,文本、圖像和圖文對三種模態數據隨機混合在一起,其中圖像被轉換為目標(object)序列,文本被轉換為詞(token)序列,圖文對被轉換為目標序列和詞序列的拼接。UNIMO 對三種類型數據進行統一處理,在目標序列或者詞序列上基于掩碼預測進行自監督學習,并且基于圖文對數據進行跨模態對比學習,從而實現圖像與文本的統一表示學習。進一步的,這種聯合學習方法也讓文本知識和視覺知識互相增強,從而有效提升文本語義表示和視覺語義表示的能力。

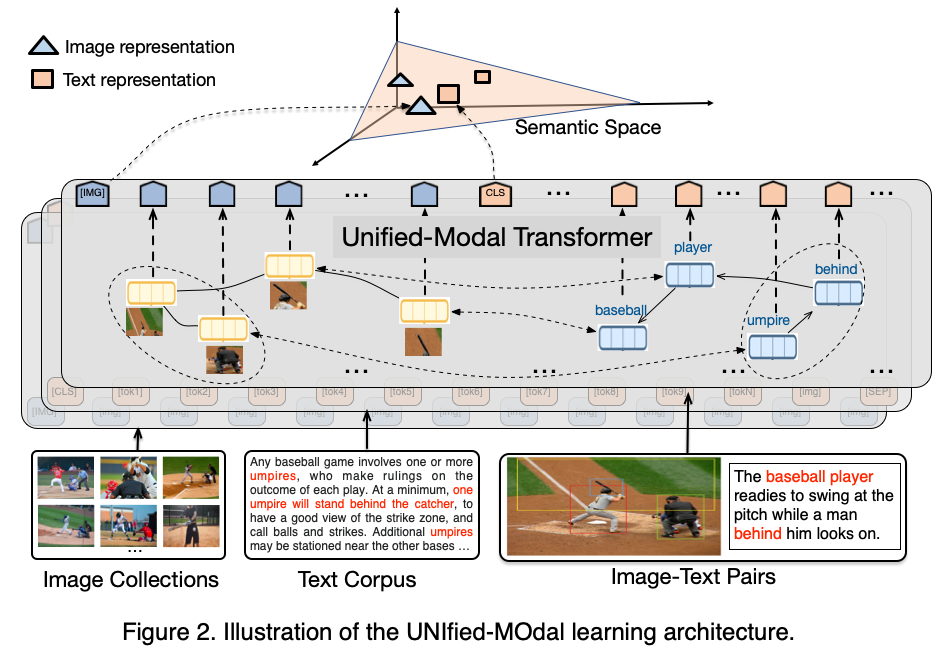

異構模態的統一預訓練最大的挑戰是如何跨越不同模態間的語義鴻溝從而實現語義表示的統一。如下圖所示,UNIMO 提出了創新的跨模態對比學習方法,同時引入相關聯的圖文對數據、文本數據和圖像數據進行聯合對比學習。具體地,UNIMO 通過文本改寫的方式,對圖文對進行數據增廣,獲得大量的正例和強負例圖文對數據。同時為了更好的利用文本和圖像數據,UNIMO 通過文本與圖像檢索,獲得相關的圖像和文本作為正例。這樣利用擴充后的多種類型的正例以及高質量強負例,UNIMO 在統一的語義空間上進行聯想對比,從而能夠學習到精確對齊的跨模態語義表示。

UNIMO 實驗結果

在實驗方面,UNIMO 使用了大量的文本、圖像和圖文數據進行聯合學習,同時在各種單一模態和跨模態下游任務上進行驗證。預訓練數據部分,文本語料包括 Wikipedia、BookCorpus、OpenWebText 等共 54G 語料;圖像數據是從互聯網爬取的 170 萬張圖像;而圖文對數據則包括 COCO Caption、Visual Genome、Conceptual Caption、SBU Caption。下游任務既包括圖文搜索、視覺問答、圖描述生成、視覺推斷等跨模態任務,也包括文本分類、閱讀理解、文本摘要、問題生成等各種文本任務。模型上,Base 基于 12 層的 Transformer,而 Large 使用 24 層。

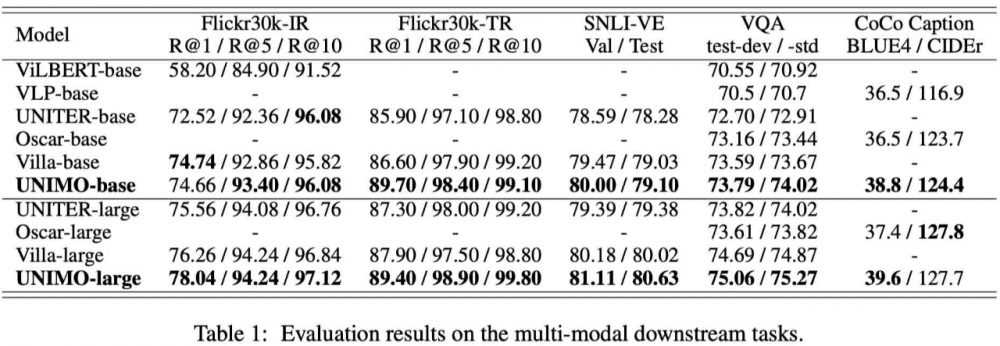

在跨模態任務上,論文主要對比 ViLBERT、UNITER、Oscar、Villa 等最新的跨模態預訓練模型。實驗結果表明,UNIMO 在圖文檢索 Flick、視覺推斷 SNLI-VE、視覺問答 VQA、圖描述生成 CoCo Caption 上均穩定地超過此前的各種預訓練模型,充分說明了統一預訓練 UNIMO 模型能夠有效地處理各種跨模態任務。

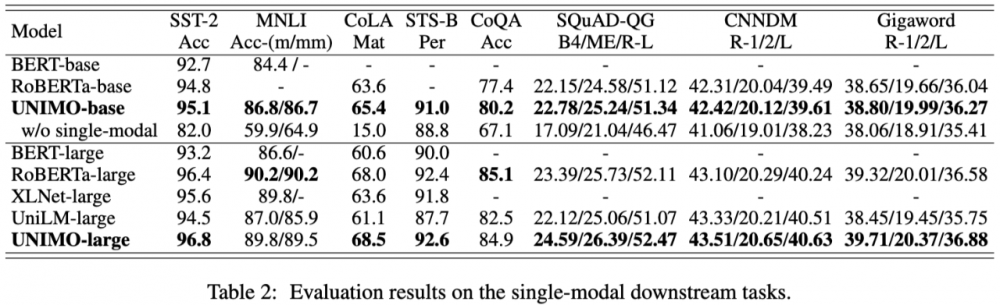

特別地,UNIMO 同時還能處理純文本任務。此前的跨模態預訓練模型,在處理純文本任務的時候效果急劇下降,部分任務下降幅度甚至超過 10-20 個點。而 UNIMO 在各類文本理解和生成任務上,包括文本分類、文本推斷、文本摘要、閱讀理解和問題生成,均取得不錯的效果,超過 RoBERTa、XLNet、UniLM 等經典文本模型。

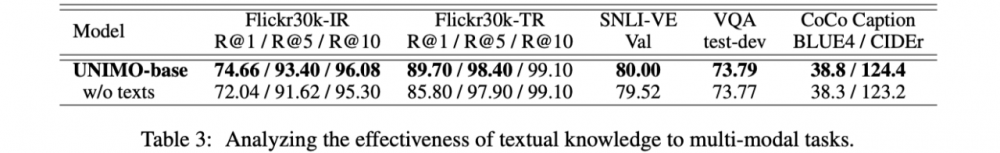

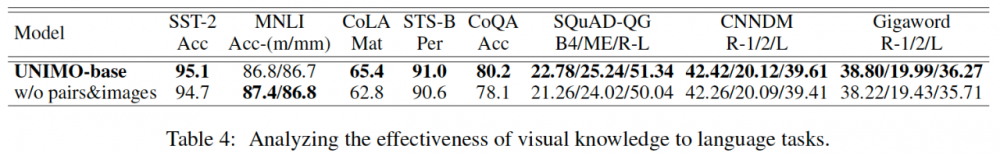

為了驗證 UNIMO 進行單一模態和跨模態統一學習的必要性,論文進行了分離實驗。實驗結果表明,當不使用文本數據進行預訓練的時候,UNIMO 在跨模態任務上效果有所下降。而當不使用圖文對數據和圖像數據的時候,UNIMO 在文本任務上同樣會下降。這充分說明,UNIMO 統一學習的方式,能夠讓文本知識與視覺知識相互增強,有效提升任務效果。

UNIMO 應用

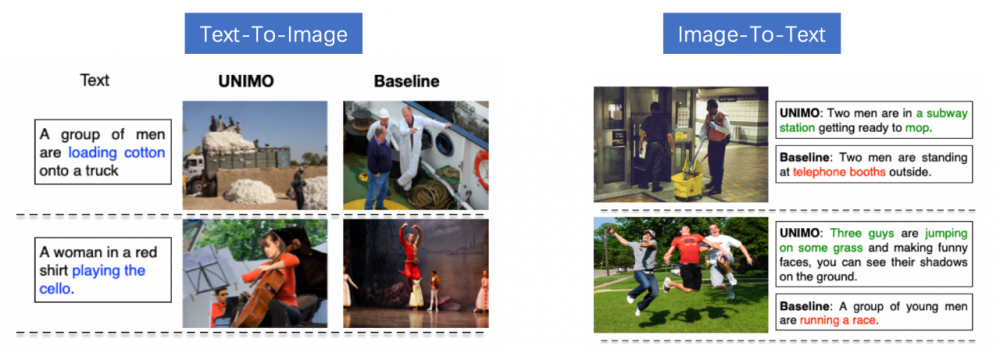

UNIMO 可以支持各類文本與跨模態任務,既可以支持以文搜圖和以圖搜文,也能支持根據圖片生成文字描述、根據文字描述自動生成圖片,還支持對圖片內容進行問答。當然,UNIMO 也支持純語言的任務,如文本推理、閱讀理解、文本生成等。從實際應用任務的結果來看,研究發現 UNIMO 能夠讓視覺和語言互相增強,從而實現更好的應用效果。目前部分技術已經開始在百度搜索中落地,幫助用戶獲取更符合需求的圖片、視頻。這里看下實際任務上的樣例效果。

跨模態檢索:以文搜圖、以圖搜文

UNIMO 能夠根據文字描述搜索相關圖片,或者根據圖片搜索相關文本描述。從結果上看,UNIMO 能夠更準確的理解文字或圖片的語義,檢索出更匹配的圖片或文字。

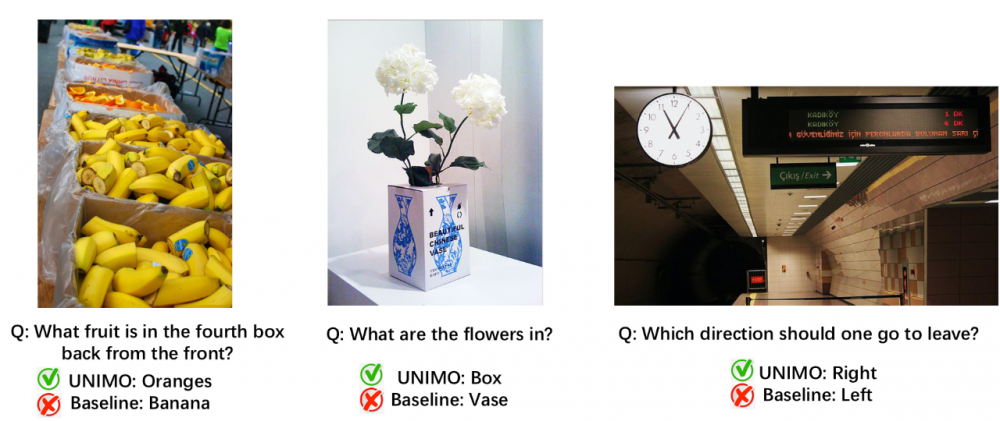

跨模態問答:

UNIMO 也支持使用自然語言對圖片內容進行提問。UNIMO 能理解圖片中的內容和概念,并結合模型學習到的背景知識,準確的進行推理回答。

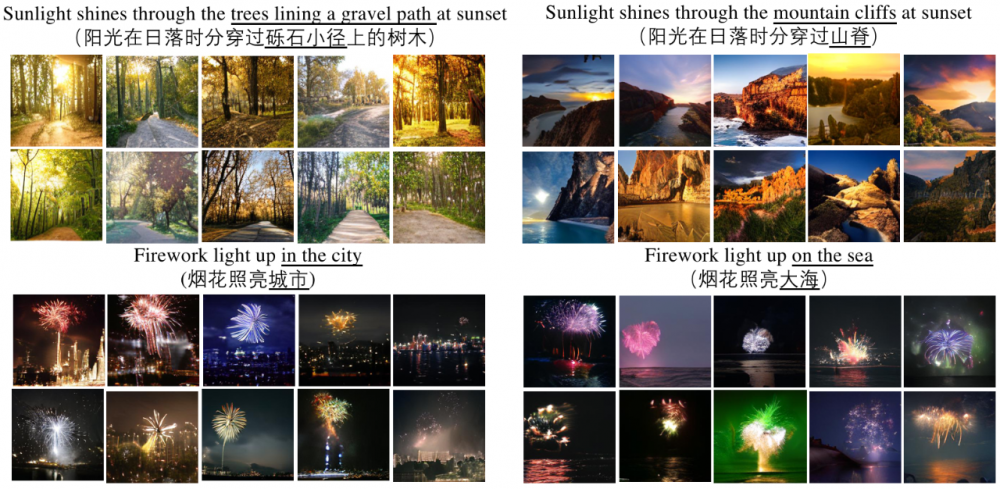

跨模態生成:根據文字生成圖片

UNIMO 能夠根據文字描述生成對應的圖片。從結果中,我們可以發現 UNIMO 能夠很好的對齊視覺和語言的屬性和概念,從而生成準確清晰的圖片。

百度首創地提出了語言與視覺一體的預訓練方法 UNIMO,提供了一種新的統一模態學習范式,打破了文本、圖像和圖文對等數據間的邊界,讓機器可以像人一樣利用大規模異構模態數據,學習語言知識與視覺知識并相互增強,從而實現感知與認知一體的通用 AI 能力。或許,異構模態的統一學習是邁向通用人工智能的關鍵節點之一。未來百度將在統一模態學習上做出更多工作和應用,敬請期待。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。

電度表相關文章:電度表原理