MLOD:基于魯棒特征融合方法的多視點三維目標檢測

注:這是一篇2019年9月發表在arXiv【1】激光雷達和攝像頭數據融合的目標檢測論文。

摘要

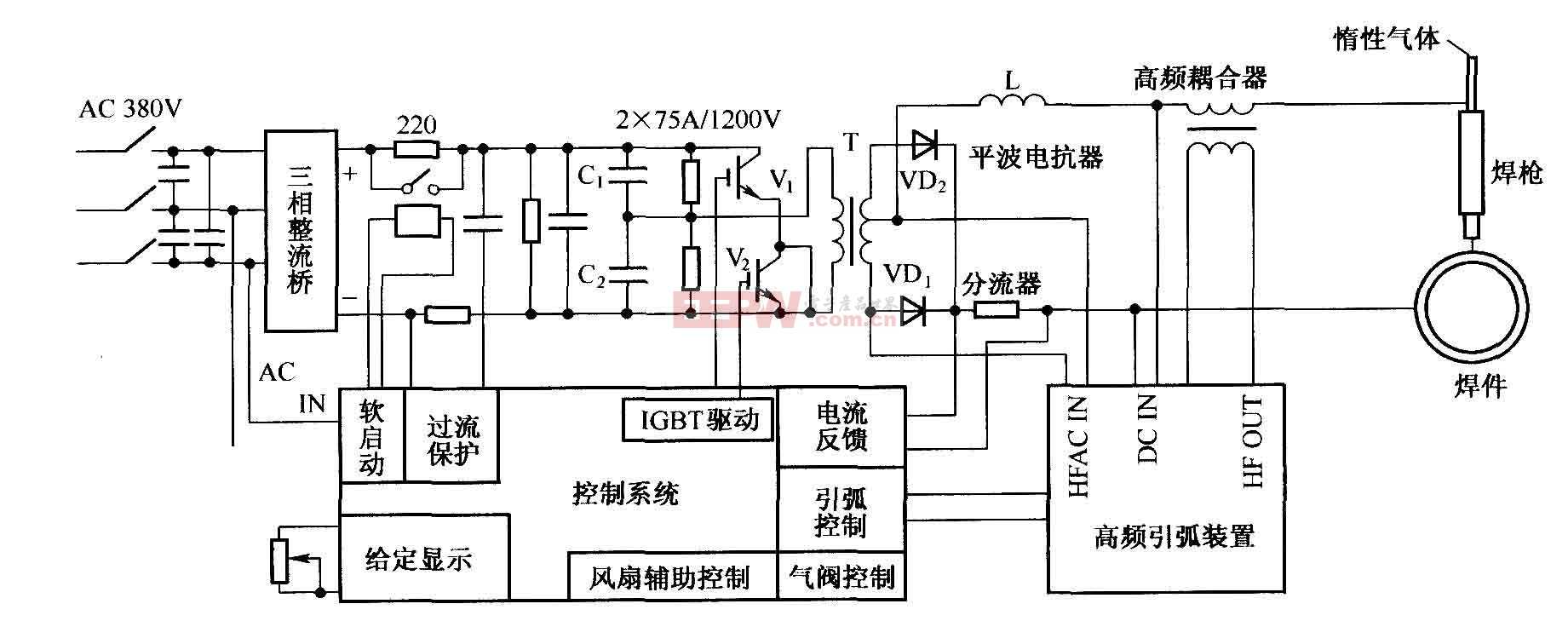

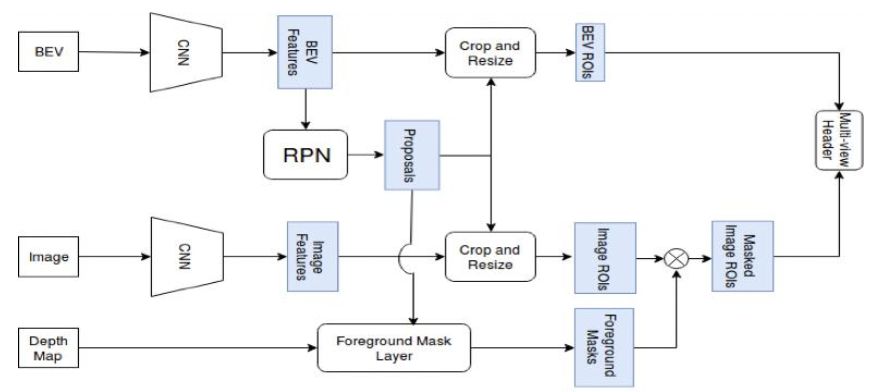

本文介紹了一個多視圖標記的目標檢測器(MLOD)。檢測器將RGB圖像和激光雷達點云作為輸入,并遵循兩步目標檢測框架。區域提議網絡(RPN)在點云的鳥瞰視圖(BEV)投影中生成3D提議。第二步將3D提議邊框投影到圖像和BEV特征圖,并將相應的圖截取發送到檢測頭(detector head)以進行分類和邊界框回歸。與其他多視圖方法不同,裁剪的圖像特征不直接饋送到檢測頭,而是被深度信息掩蓋以過濾掉3D邊框外的部分。圖像和BEV特征的融合具有挑戰性,因為它們來自不同的視角。這里引入了一種新檢測頭,不僅可以從融合層提供檢測結果,還可以從每個傳感器通道提供檢測結果。因此,可以用不同視圖標記的數據訓練目標檢測器,以避免特征提取器的退化。MLOD在KITTI 3D目標檢測基準測試中實現了最好的性能。最重要的是,評估表明新的頭架構(header architecture)在防止圖像特征提取器退化方面是有效的。

1.MLOD架構

大約有三種方法可以利用攝像頭和激光雷達做自動駕駛的3D目標檢測:1)圖像區域建議,2)基于投影和3)多視圖方法。

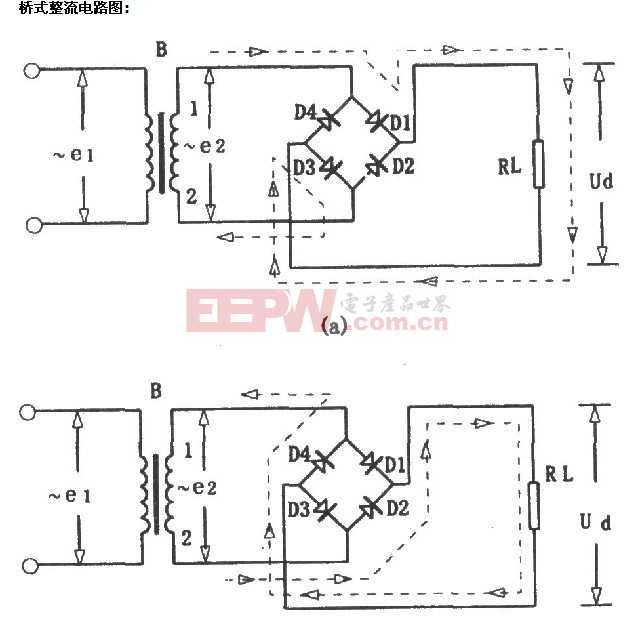

本文提出的兩步神經網絡結構如圖1所示。BEV圖和RGB圖像被饋入兩個卷積神經網絡獲得特征。為了提高計算效率,僅使用RPN的鳥瞰視圖(BEV)特征生成3D提議。基于提議的深度信息,3D提議之外的圖像特征被前景掩碼層(foreground mask layer)掩蓋。然后,掩碼的圖像特征圖和BEV特征圖被裁剪并傳遞到多視圖頭(multi-view header),提供最終的分類、定位和定向結果。

圖1

6個通道的BEV圖輸入是一個0.1米分辨率的2D網格,包括5個高度通道和1個密度通道。點云沿著地平面的法線在[0, 2.5米]之間被劃分為5個相等的切片(slices),并且每個切片產生高度通道,每個網格單元表示該單元中的點的最大高度。

該模型采用U-Net結構作為BEV特征提取器。編碼器部分類似VGG的CNN,但有一半的通道。它包括CNN層,最高可達conv-4層。在****部分中,特征提取器使用卷積轉置(conv- transpose)操作對特征圖上采樣。上采樣特征圖與來自編碼器的相應特征串聯實現融合。圖像特征提取器是在pool-5層之前的VGG16 CNN。

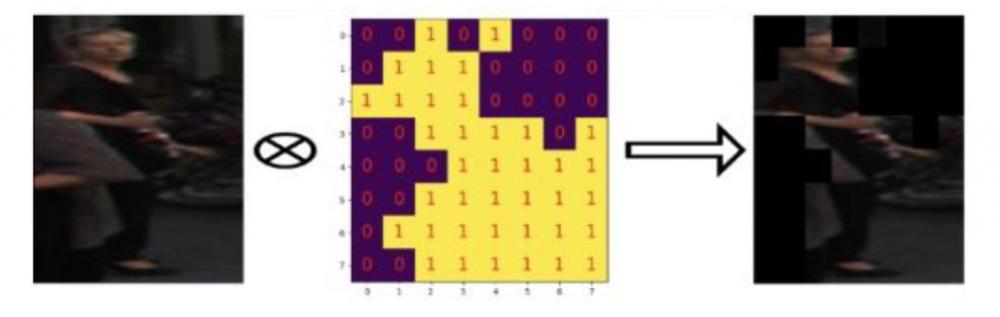

為在提議的3D邊框內正確捕獲目標的圖像特征,本文引入了前景掩碼層來過濾掉前景特征。

為了識別圖像的前景和背景,具有每個像素深度信息是必要的。但是由于激光雷達點云的稀疏性,圖像平面中的大部分深度信息都是未知的。最近,有幾種方法來完整化深度圖。不幸的是,它們通常具有高GPU內存使用率,不適合實現。相反,這里引入了一種輕量級方法來利用稀疏深度信息。

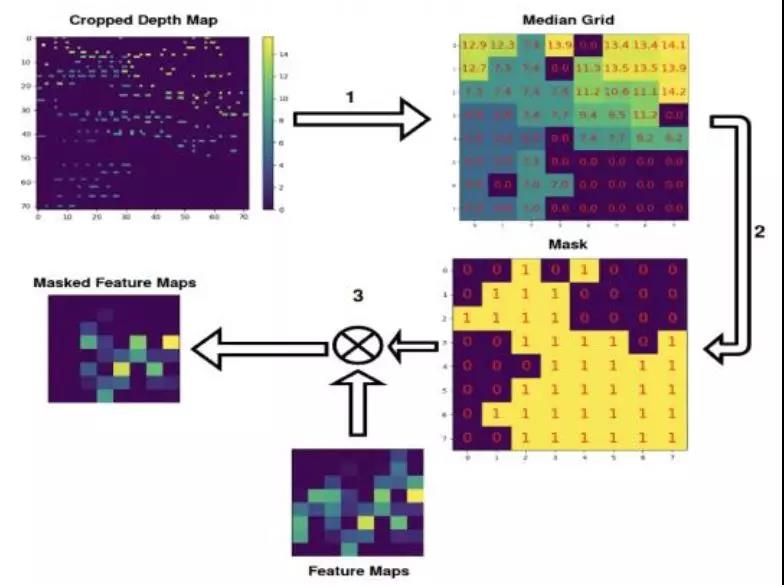

圖2顯示了前景掩碼層的流程。首先,該層用3D提議投影的前視2D邊框裁剪并調整其(稀疏)深度圖的大小。為了計算方便,調整大小的深度圖是k×k大小裁剪圖像特征圖的n倍。由于深度信息在前視圖是不連續的,因此使用最近鄰內插算法獲得大小調整過的深度圖。然后將nk×nk深度圖等分成k×k網格。這樣,每個網格單元表示k×k圖像特征圖對應像素的深度信息。該層計算每個網格單元中非零深度值的中值mij,因為零值表示該像素沒有激光雷達點信息。請注意,由于點云的稀疏性,網格單元格中的所有深度值都可能為零。

(a)

(b)

圖2

由于遠目標只有較少的投射激光雷達點,因此這些目標的某些部分沒有任何深度信息。為此,為保留3D邊框內或沒有深度信息的圖像特征,將前景掩碼設置為前視圖,使用最近鄰內插算法獲得調整大小的深度圖。然后,將nk×nk深度圖等分為k×k網格。因此,每個網格單元表示k×k圖像特征映射中的對應像素的深度信息。因此,為了保留3D邊界框內的圖像特征或沒有深度信息,我們將前景掩碼設置為

其中dmax和dmin分別是3D邊框的最大和最小深度值。ε1和ε2是小緩沖區,用于吸收3D提議和點云的不確定性。(圖2中dmin = 6.8,dmax = 9.7)

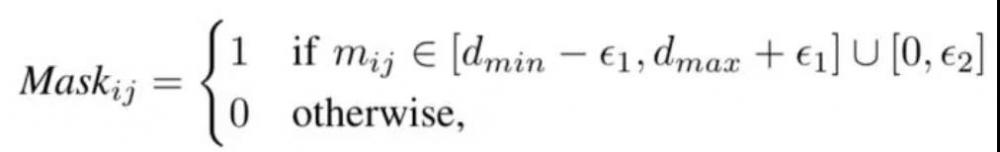

在多視圖3D目標檢測方法中,基于BEV的IoU來分配提議標簽。但前視圖的IoU可能與BEV的IoU明顯不同。圖3示出將3D邊框分配給負標簽但在圖像視圖中IoU > 0.7的示例。當僅基于BEV IoU分配標簽來訓練目標檢測器時,(前視圖)圖像通道的性能降低。

圖3

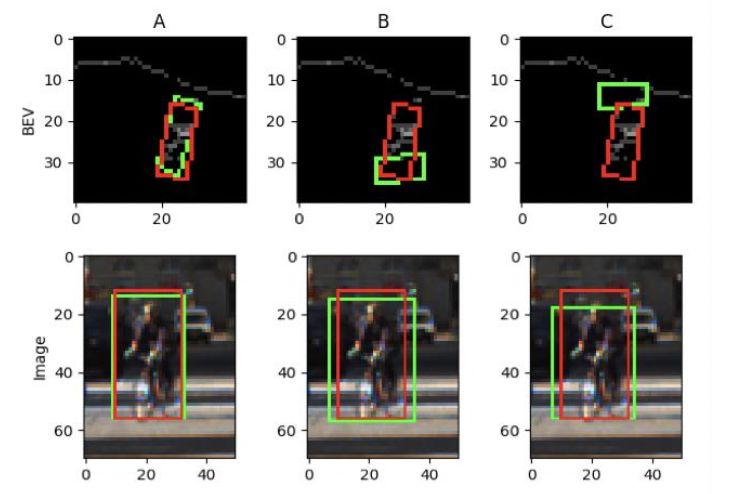

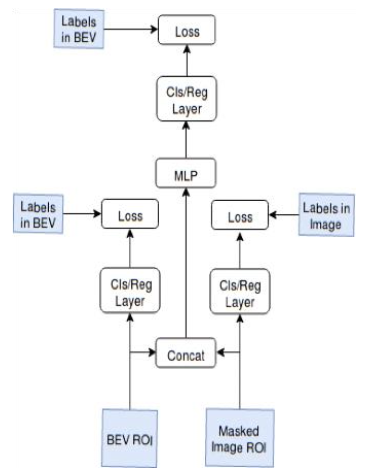

作者提出了一種多視圖檢測頭,以避免RGB圖像特征的衰減。圖4顯示了頭部網絡結構。關鍵想法是在融合層(concat)之前為每個通道添加額外的輸出層。兩個輸出的每一個饋入到相應的子輸出(sub-output)損失中。每個子輸出損失是采用在相應通道視圖中IoU分配的標簽計算,即

圖4

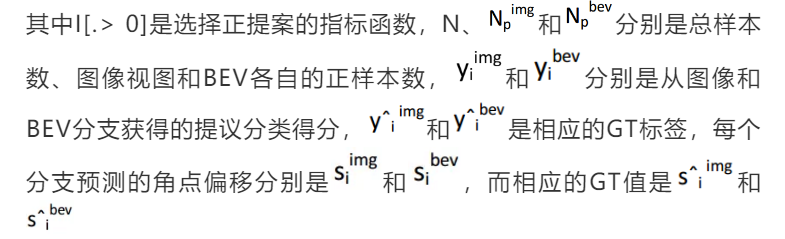

2.網絡訓練

文中使用多任務損失來訓練網絡,其檢測網絡的損失函數由下式定義

這里使用平滑L1損失進行3D邊框偏移和朝向旋轉回歸,并使用交叉熵損失進行分類。λ是用于平衡不同損失項的超參數。子輸出損失可以被認為是網絡上的一種正則化過程。

KITTI基準測試對汽車類(> 0.7)和行人和騎車者類(> 0.5)使用不同的IoU閾值。因此,文中訓練了兩個網絡,一個用于汽車,另一個用于行人和騎自行車者。用大小是1024個ROI的微批量聯合訓練RPN網絡和檢測頭。采用ADAM優化器【2】,指數衰減的學習率初始化為0.0001。在汽車網絡,每100K迭代衰減0.1。在步行者和自行車者網絡,每20K迭代衰減0.5。圖像特征提取器加載預訓練的ImageNet權重。BEV特征提取器權重由Xavier統一初始化器(uniform initializer)初始化。

如果BEV /圖像和真實GT目標的IoU分別大于0.65 / 0.7,則汽車建議在自上而下/前視圖中被標記為正。如果其BEV /圖像IoU分別小于0.55 / 0.5,則標記為負。正的行人或騎車者建議在BEV /圖像視圖中至少分別為0.45 / 0.6 IoU。負樣本分別在BEV /圖像視圖中不超過0.4 / 0.4 IoU。對于微批量大小,先選擇1024個樣本,包括在自上而下的視圖中具有最高RPN分數的正ROI和負ROI;然后,在正面視圖中挑選正或負的ROI。

有許多方法可以編碼3D邊框。為了減少參數的數量并保持物理限制,3D邊框表示為X-Y平面上的四個角,頂部和底部角高度會偏離地平面。

數據增強是增加訓練實例數量和減少過擬合的重要技術。在這里的網絡訓練中實現了兩種增強方法,即翻轉和PCA抖動。點云和圖像沿x軸翻轉。PCA抖動會改變訓練圖像中RGB通道的強度。PCA分解應用在整組訓練圖像RGB像素值的集合中。然后,將高斯隨機噪聲添加到圖像的主分量中。

3.實驗

主要評估KITTI目標檢測基準測試中汽車、行人和騎車人3D檢測任務的MLOD性能。KITTI的3D目標檢測數據集包含7,481個訓練幀和7,518個測試幀。基于遮擋級別、最大截斷和最小邊框高度,這些幀包含三個難度級別的目標級對象:簡易(E),中等(M)和難(H)。由于KITTI沒有提供官方驗證集,標記的7,481幀被分成訓練集和1:1比例的驗證集。

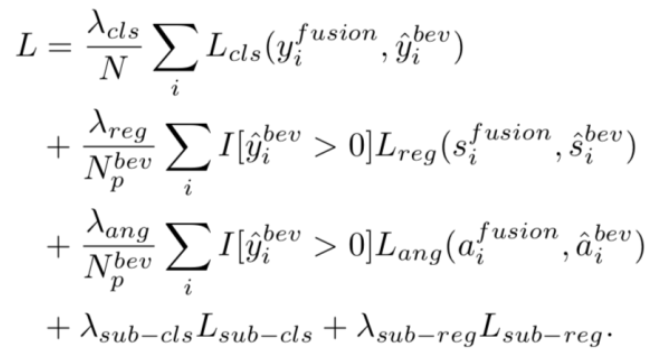

圖5展示了實驗結果例子。每張圖像檢測到的車輛為綠色,行人為藍色,騎車者為黃色。

圖5

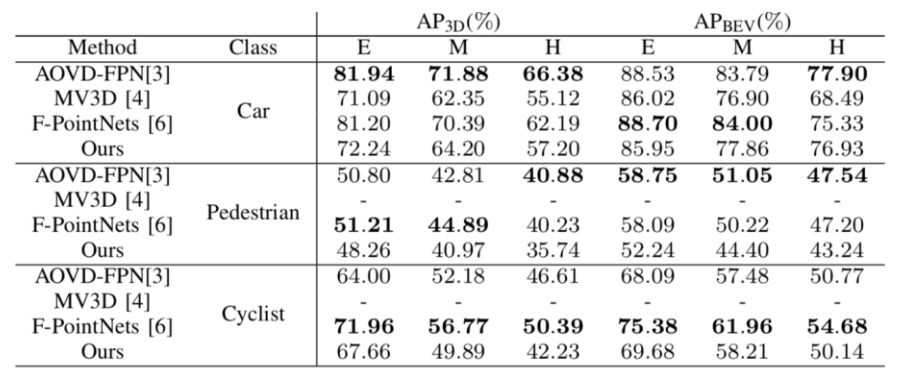

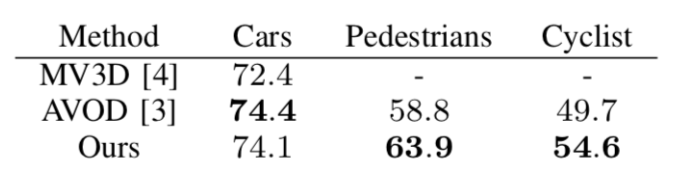

為評估MLOD的性能,分別在表II和表I中給出驗證集和KITTI測試集的平均精度(AP)結果。MLOD在驗證集上優于其他兩個最先進的多視圖目標檢測器【3-4】。但是,MLOD方法在KITTI測試集上比AVOD差。這可能是由MLOD和AVOD中使用不同地平面引起的。評估表明,該方法可以達到當前最佳性能。

表I:MLOD與當前3D目標檢測器的性能比較

表II:在中等難度驗證集上MLOD與當前3D目標檢測器的AP3D比較

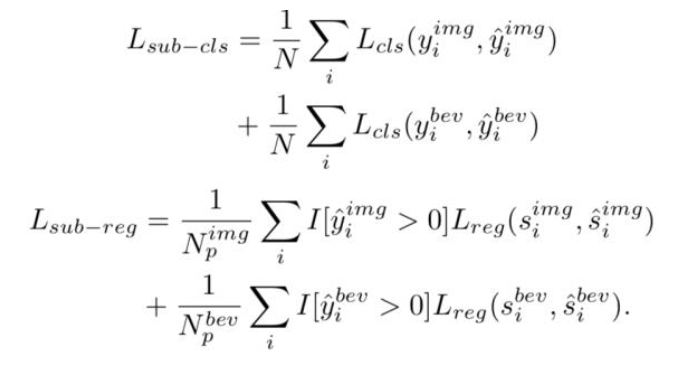

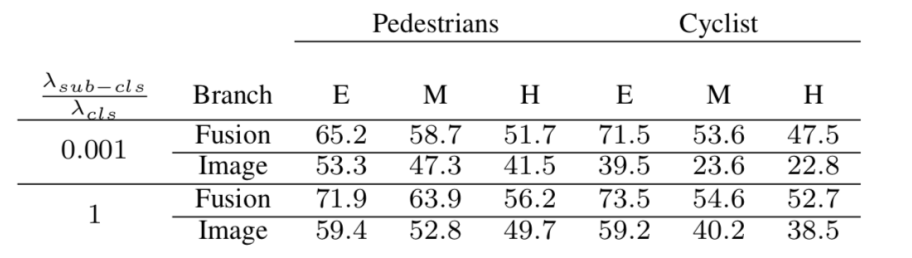

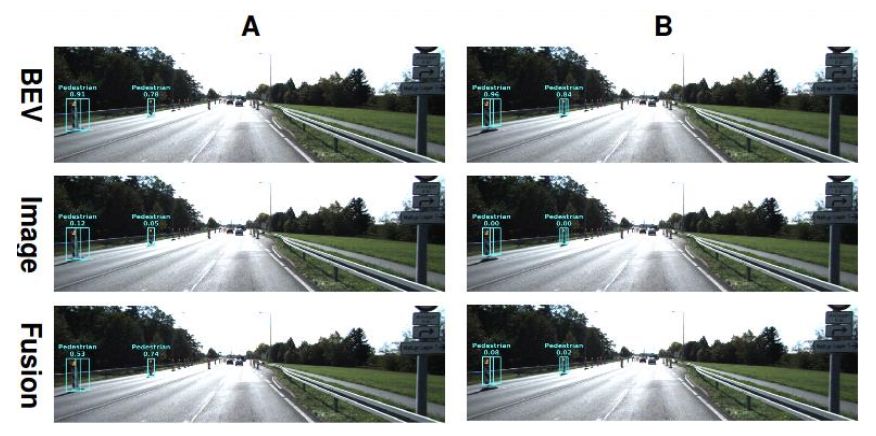

為評估多視圖頭網絡的影響,將MLOD的AP(%)與驗證集不同λsub-cls設置進行比較,如表III。當λsub-cls /λcls= 0.001時,BEV標記樣本的融合通道支配了網絡訓練,這時候子通道損失可忽略。表III顯示多視圖頭網絡可為圖像通道提供顯著的性能增益,范圍從5%到20%不等。對行人檢測的容易、中等和難三種級別,AP最終檢測分別增加了6.7%,5.2%和4.5%。圖6顯示了多視圖頭網絡的效果示例(A欄:λsub-cls /λcl = 0.001; B列:λsub-cls /λcl = 1)。注意:當λsub-cls /λcls= 1,圖像通道正確地為激光雷達BEV中誤報的行人記分0.0。

表III 不同的λ設置在驗證集上評估MLOD的AP3D性能

圖6

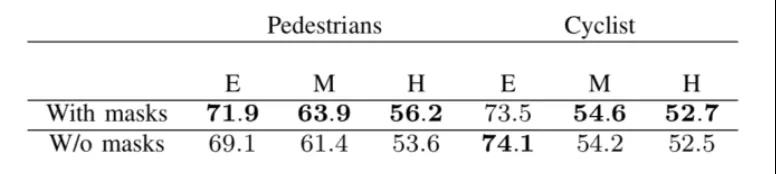

表IV顯示了掩碼組件如何影響MLOD的性能。

表IV 前景掩碼層的效果

本文作者簡介:

黃浴,奇點汽車美研中心總裁和自動駕駛首席科學家,上海大學兼職教授。曾在百度美研自動駕駛組、英特爾公司總部、三星美研數字媒體研究中心、華為美研媒體網絡實驗室,和法國湯姆遜多媒體公司普林斯頓研究所等工作。發表國際期刊和會議論文30余篇,申請30余個專利,其中13個獲批準。

*博客內容為網友個人發布,僅代表博主個人觀點,如有侵權請聯系工作人員刪除。

紅外遙控器相關文章:紅外遙控器原理