AI芯片研究現狀及體系結構

為了應對不同場景的智能計算任務,AI芯片誕生了不同的分支,包括適用于各種大規模網絡訓練的大算力、高功耗通用AI芯片和適用于特定應用、在邊緣設備(如機器人)上進行智能計算的專用AI芯片。基于人工智能的感知、定位與導航技術與眾多機器人應用相關,這些技術通常具有高算力需求。因此,專用AI芯片對機器人的智能化應用具有重要意義,學術界和工業界一直致力于高性能AI芯片架構的設計。

隨著網絡模型的不斷增大,研究人員發現單純依賴高性能硬件架構的設計已然無法滿足最先進網絡在專用AI芯片上的高效部署,而新興的軟硬件結合加速技術為問題的解決帶來了突破口,并得到廣泛重視和大量研究。

當前存在的人工智能芯片可被劃分為通用芯片、專用芯片和可重構芯片三大類。

通用芯片主要包括中央處理器(CPU)和圖形處理器(GPU)。這兩種芯片基于馮·諾依曼體系結構,以控制流作為驅動,具有很強的靈活性與通用性。

早在20世紀60年代,計算機工業就開始廣泛使用CPU這一術語。隨著技術的進步和數十年的發展,CPU的設計技術和計算性能不斷提升,但CPU的基本原理保持不變。CPU的架構如圖所示,其中算術邏輯單元(ALU)模塊用于執行邏輯運算,而指令集訓(IR)、指令程序計數器(PC)等模塊則確保指令能夠有序執行。

為了提高CPU的計算性能,像英特爾和AMD等全球頂級CPU制造商致力于多核設計、超頻等方面的技術突破。然而,隨著深度學習等計算密集型任務的興起,CPU面臨著嚴重的算力依賴性挑戰。特別是在散熱和功耗的限制下,無法無限制地提高CPU的工作頻率以滿足計算需求,這就導致了在CPU平臺上部署神經網絡時遇到了不可逾越的鴻溝。

神經網絡的訓練和推理過程對大量的計算資源和高效的數據處理能力有著極高的要求,而現代CPU在這些方面的表現往往無法完全滿足。

GPU的出現不僅彌補了CPU算力不足的缺陷,而且極大地推動了人工智能技術的發展。與CPU不同,GPU在單位面積上集成了更多數量的處理單元。如英偉達在2024年推出的GeForce RTX 4090顯卡擁有16384個CUDA核心,而同時期最先進的英特爾Core i9處理器最高僅有24個核心。因此,相比CPU,GPU在應對大規模并行運算時更具優勢,能夠實現1到2個數量級的性能提升。

同時,GPU巨頭英偉達不斷改進硬件架構和編程模型,工業界和學術界越來越多地將GPU應用到神經網絡的訓練與推斷。2012年的ImageNet挑戰賽上僅有4支參賽隊伍使用GPU;而到了2014年,幾乎所有隊伍都使用了GPU。到如今,隨著網絡深度不斷加大,尤其大模型的出現導致參數量突破千億,因此對GPU的依賴更加嚴重。

然而,CPU和GPU這種基于馮·諾依曼體系結構的通用芯片在智能計算應用中遇到以下問題:

① 任務的執行涉及大量“取指”“譯碼”“寄存器訪問”和“數據回寫”等輔助性操作,限制了處理器性能,降低了能效;

② 存儲與運算分離的計算架構無法高效適配智能計算這種訪存量巨大的任務,頻繁的數據交換導致大量功耗浪費和嚴重的網絡處理延遲;

③ 馮·諾依曼架構的計算單元位寬固定,無法支持多精度協同運算。

鑒于GPU和CPU的上述缺陷,低功耗、高性能的專用芯片應運而生,并逐漸在網絡加速中嶄露頭角。

在2016年和2017年,Facebook、微軟、亞馬遜AWS、阿里云等發布了基于可重構芯片的云計算服務。2017年以來,專用芯片成為學術界和工業界的研發熱點 —— 如谷歌在服務器中使用的TPU(Tensor Processing Unit)就是一項被大規模部署、證明有效的GPU替代方案。

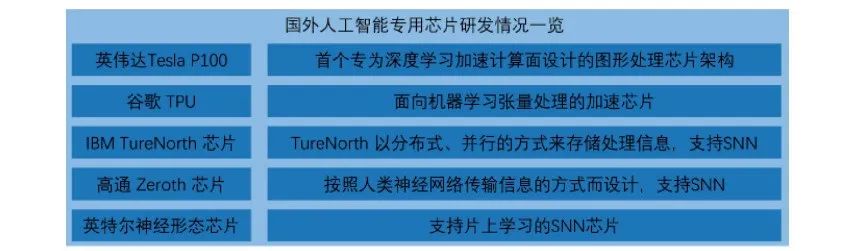

所謂專用智能芯片,主要是指基于ASIC和FPGA方法設計的定制處理器。ASIC這類面向計算任務進行有針對性設計的芯片能夠實現以毫瓦級的功耗取得高達100~1000GOP/W的算力,因而適配于智能計算。隨著近些年來人工智能算法的爆炸式發展和相關技術的逐漸成熟,專用智能芯片的優勢逐漸凸顯,因而有大量國內外公司參與到此類芯片的研發,研發情況如圖所示。

雖然ASIC芯片在功耗、可靠性和集成度上頗具優勢,且在有高性能、低功耗需求的邊緣計算場景下尤其凸顯。然而,ASIC芯片本身也存在著固有的缺陷,比如電路設計需要定制、開發周期長、功能難以擴展、無法根據神經網絡架構的不同來更改計算架構等。

FPGA是對GPU與ASIC的折中選擇,其發展歷程如圖所示。FPGA的原理是在芯片內部署大量基本的門電路與存儲器,通過更改FPGA的配置文件來定義這些門電路與存儲器之間的連接。基于可重構芯片的智能加速汲取了通用芯片與專用芯片的優勢,在擁有定制化電路高性能優勢的同時,又具備相當的通用性。

FPGA摒棄了傳統馮·諾依曼架構命令執行流程中需要有指令存儲器、譯碼器、各種指令的運算器及分支跳轉處理邏輯參與的問題,極大地降低了計算任務執行功耗,能耗比得到大幅提升。另一方面,FPGA的靈活性使其克服了ASIC無法實現電路級可重構定制化的問題,為算法的功能實現和優化留出了更大的空間。而且,FPGA的一次性成本遠低于ASIC。由于上述優勢,FPGA在眾多領域逐漸出現替代ASIC與GPU的趨勢。

值得注意的是,數據流占據高性能機器人專用AI芯片設計的半壁江山,一個高效的數據流能夠提高數據復用率,降低功耗代價高昂的片上、片外內存訪問頻率是設計機器人專用AI芯片必不可少的一環。

評論