邊緣側 AI 工作負載的系統性演進

——在性能確定性、隱私保護與安全可信之間構建工程閉環

一、從“算力在哪里”到“系統責任在哪里”

如果說早期 AI 架構討論的核心問題是“算力是否足夠”,那么在 2025 年,這個問題已經明顯過時。真正困擾產業的,是系統責任的歸屬:

決策是在云端完成,還是在設備本地完成?

數據風險由誰承擔?

性能抖動導致的系統失效由誰負責?

在自動駕駛、工業自動化、醫療設備和智能家居等領域,AI 推理結果往往直接觸發物理世界的動作。這使得“低延遲、確定性響應、可驗證安全”不再是優化指標,而是準入門檻。

正是在這一背景下,AI 工作負載開始系統性地從云端向邊緣遷移。

二、邊緣 AI 的本質優勢:確定性,而非極限性能

在討論中,多位專家反復強調一個容易被忽略的事實:

邊緣 AI 的價值,并不在于更高的峰值算力,而在于更可預測的行為。

云端 AI 的核心優勢在于:

資源彈性;

模型快速迭代;

規模化成本攤薄。

但其弱點同樣明顯:

網絡延遲不可控;

帶寬競爭;

加密、重傳、排隊等系統級不確定性。

相比之下,邊緣側 AI 即便算力有限,卻能提供:

毫秒級穩定延遲;

本地閉環控制;

不依賴外部網絡的魯棒性。

在工程實踐中,確定性往往比平均性能更重要。

三、數據治理視角下的“邊緣優先”原則

Siemens EDA 的代表從數據治理角度,將 AI 數據處理劃分為三個層級:

感知級數據(原始傳感器輸入)

決策級數據(推理中間狀態與結果)

演進級數據(用于模型改進的統計樣本)

1. 感知與決策數據:天然屬于邊緣

家庭機器人、車載攝像頭、工業視覺系統所采集的數據,往往包含:

個人隱私;

企業機密;

場景語義信息。

這些數據一旦脫離設備,就會引發合規與信任問題。因此,感知級與決策級數據必須默認在本地完成處理。

2. 演進數據:有限、可控地回流

完全不回傳數據會導致模型“靜態化”。因此,系統通常會將:

異常事件;

決策失敗案例;

特定觸發條件下的統計特征

以匿名化、去標識化的方式上傳,用于模型再訓練。這種設計體現的是一種工程妥協,而非技術理想化。

四、內存:邊緣 AI 的“隱形天花板”

在算力之外,內存正在成為邊緣 AI 的第一約束條件。

1. 模型規模與數據并存

即便經過剪枝和量化,主流感知模型仍需要:

數百 MB 的權重;

大量中間激活值緩存;

高頻訪問的上下文數據。

這對邊緣 SoC 提出了三重挑戰:

容量不足;

帶寬受限;

訪問能耗過高。

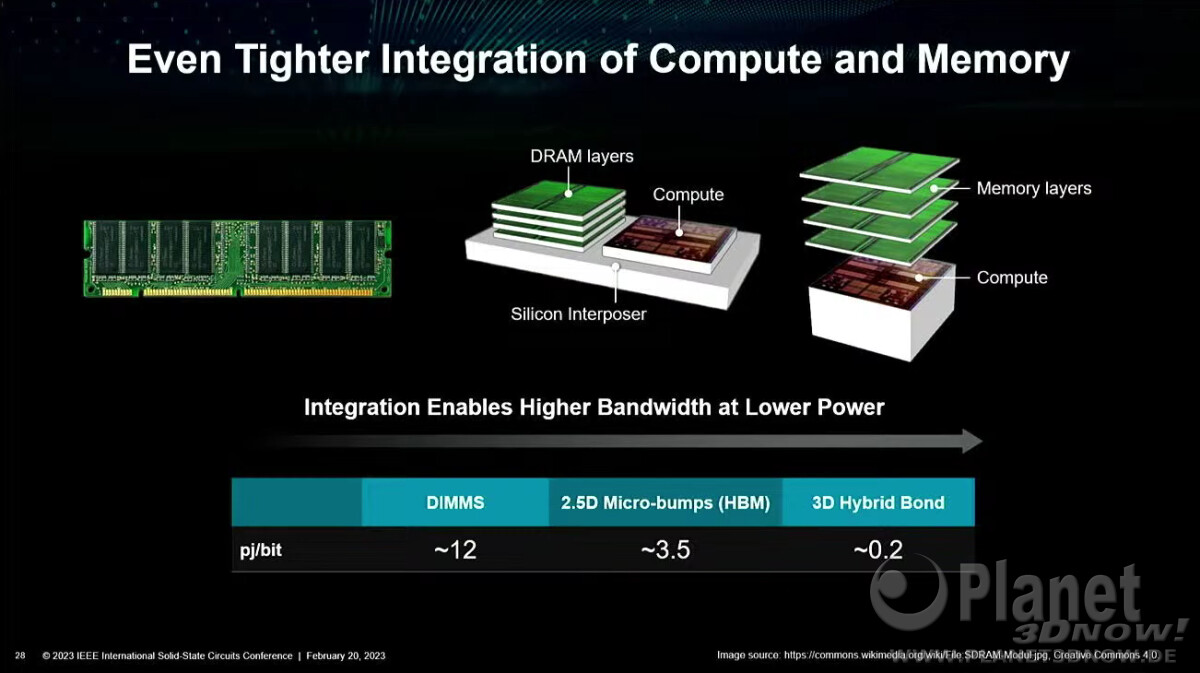

2. 共封裝 DRAM:性能與安全的交匯點

Infineon 提到的 DRAM 共封裝方案,并非單純為了“更大內存”,而是為了:

降低物理攻擊面;

縮短數據通路;

在封裝層實現安全隔離。

這意味著,封裝本身正在成為系統安全的一部分,而不再只是制造工藝問題。

五、從“加密”到“全生命周期保護”的安全升級

Rambus 提出的安全框架值得特別強調。傳統安全設計通常只覆蓋:

數據在傳輸中;

數據在存儲中。

但 AI 工作負載引入了第三個、也是最難保護的狀態:

數據在使用中(Data in Use)

近期曝光的 TEE Fail 攻擊表明,即便在“可信執行環境”中,側信道和實現缺陷仍可能導致泄露。

因此,新的安全范式要求:

解密窗口最小化;

密鑰動態管理;

硬件、固件、軟件協同驗證;

覆蓋供應鏈與物理攻擊。

安全不再是“模塊”,而是系統屬性。

六、加密與網絡:為什么云端推理越來越“昂貴”

Keysight 從測試與網絡角度指出了一個現實問題:

數據包丟失主要發生在網絡層;

加密數據包的丟失代價更高;

實時 AI 對重傳極其敏感。

這意味著:

云端推理在安全要求提高后,系統開銷呈非線性上升;

邊緣推理反而成為“更經濟”的選擇。

這也是為什么,在推理階段,AI 正在不可逆地向邊緣遷移。

七、AI 芯片設計范式的根本轉向

Siemens EDA 用一個關鍵詞總結當前趨勢:

從“硬件定義軟件”到“軟件定義硬件”。

1. GPU 的局限性逐漸顯現

GPU 的優勢在于通用性,但其問題也越來越明顯:

功耗高;

數據搬移成本大;

對嵌入式場景不友好。

2. NPU/TPU 與專用加速器的崛起

面向特定工作負載優化的 NPU,能夠在:

能效;

延遲;

確定性

方面顯著優于 GPU。這也是 Tesla 等廠商選擇自研 AI 芯片的根本原因。

八、EDA 與工具鏈:追趕變化最快的一環

Synopsys 提到一個被低估的矛盾:

算法迭代周期:幾周到幾個月;

芯片生命周期:5–10 年。

這迫使邊緣 AI 芯片必須具備:

高度可編程性;

面向未來模型的彈性;

在功耗和面積上的嚴格約束。

EDA 工具正在從“驗證設計正確性”,轉向:

協助系統級探索;

提前評估架構選擇對 AI 工作負載的影響。

九、TOPS 指標的失效與系統級性能觀

Infineon 明確指出:

單一 TOPS 指標無法反映真實邊緣 AI 性能。

真正決定性能的,是:

內存層級;

NoC 架構;

數據復用策略;

軟件映射效率。

在很多案例中,架構優化帶來的性能提升,遠高于算力翻倍。

十、多廠商、多生態:邊緣 AI 的現實復雜性

Keysight 以移動終端和 6G 為例指出,未來設備中可能同時存在:

多個 NPU;

不同廠商的軟件棧;

通信協議內嵌 AI 模型。

這對硬件提出了前所未有的要求:

跨生態兼容;

動態調度;

可驗證協同。

十一、極限協同設計與標準的重要性回歸

Siemens EDA 將當前階段稱為:

Extreme Co-Design(極限軟硬件協同設計)

其核心特征是:

架構、算法、系統同時設計;

廠商之間提前協同;

打破傳統分工邊界。

Rambus 最后強調:

沒有標準,就沒有規模化生態。

標準雖然滯后,但它是防止邊緣 AI 走向碎片化和封閉化的唯一現實工具。

十二、結語:邊緣 AI 是系統工程的必然選擇

綜合本次討論可以得出一個清晰結論:

邊緣 AI 的成功,不取決于單點技術突破,而取決于系統級平衡能力。

未來成熟的邊緣 AI 平臺,必然具備:

數據默認本地處理;

全生命周期安全;

架構驅動性能;

軟硬件深度協同;

面向標準和生態開放。

這不是一次簡單的“算力下沉”,而是一場AI 工程范式的重構。

評論