HBM4以前所未有的內存帶寬推動下一代人工智能

DeepSeek R1的首次亮相在AI社區掀起了波瀾,不僅因其能力,更因其開發規模之大。這款擁有6710億參數的開源語言模型發布,標志著人工智能的一個關鍵時刻,因為它在超過20萬億個令牌上訓練,使用數萬臺NVIDIA H100 GPU,凸顯了大型語言模型(LLMs)領域對數據的巨大需求。

H100能夠處理如此龐大的數據吞吐量的關鍵在于其對HBM3內存的依賴。每塊 H100 SXM GPU 使用 80 GB HBM3 內存,提供 3.35 TB/s 帶寬。雖然這相較于前幾代有了顯著進步,但GPU的內存容量和帶寬增長速度仍不足以跟上AI模型的指數級增長。

例如,H100 提供的內存容量和帶寬是 NVIDIA 上一代 A100 GPU 的兩倍,后者最初提供 40 GB HBM2 內存和 1.55 TB/s 帶寬。然而,過去兩年AI模型的規模增長了100倍以上——遠遠超過了內存增長。

這一差距凸顯了人工智能發展中的一個關鍵挑戰:傳統記憶技術根本無法滿足現代人工智能訓練的帶寬和容量需求。龐大的數據集需要快速訪問和處理,如果內存容量和性能不足,AI計算資源就會被低估。

高帶寬內存登場

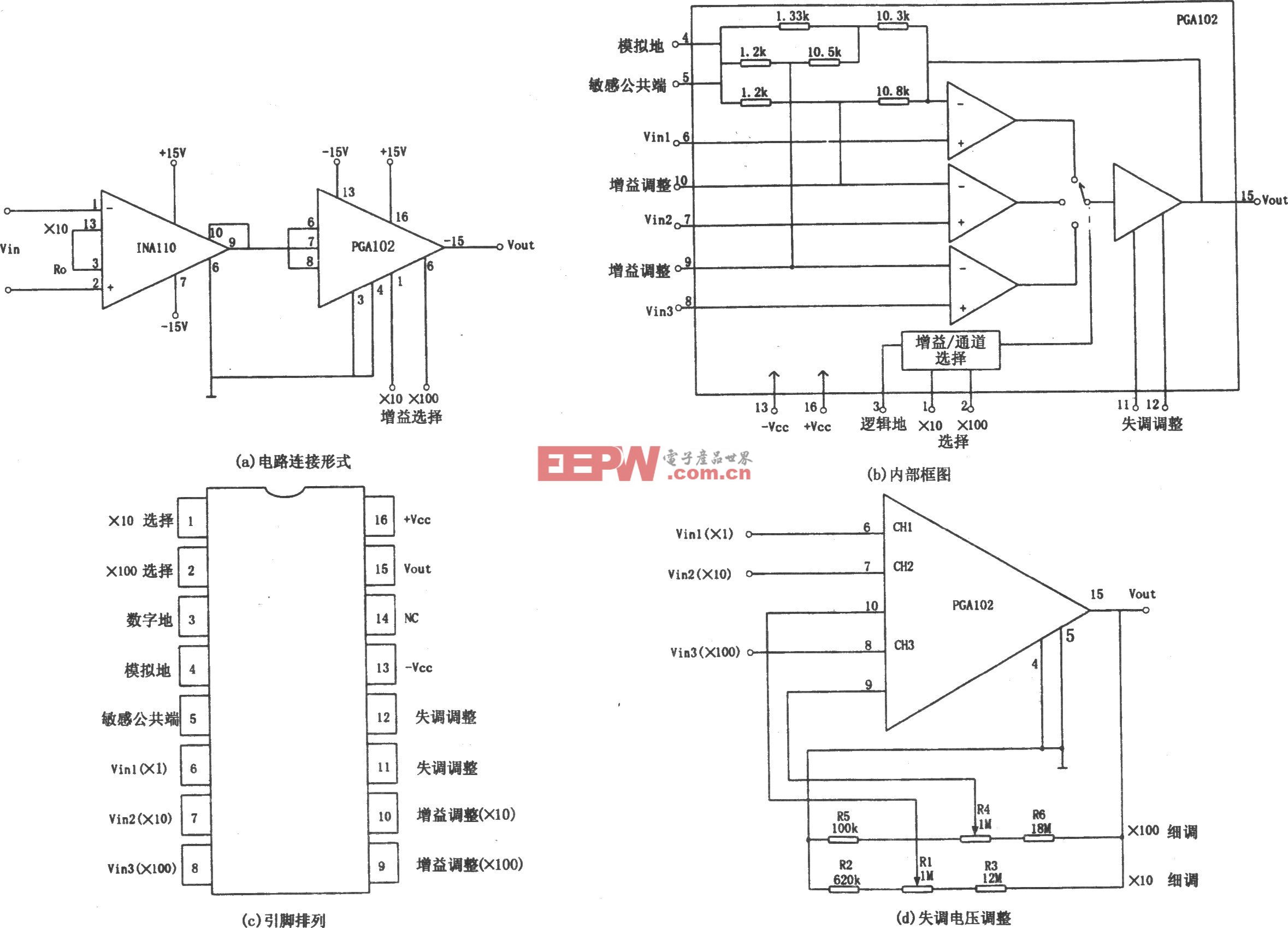

這正是高帶寬存儲器(HBM)派上用場的地方(見表)。通過垂直堆疊內存芯片并連接寬大且高速的接口,HBM相比傳統內存架構在性能和容量上實現了顯著飛躍。它迅速成為高級AI工作負載的首選內存解決方案。

高帶寬存儲器(HBM)在容量和性能上都有所提升。(圖片來源:Rambus)

HBM的發展非常顯著。它以1 Gb/s的數據速率和最多八個16 Gb芯片組成的3D堆棧啟動。通過HBM3e作為HBM3的增強版,數據速率可擴展至9.6 Gb/s,設備可支持最多16個32 Gb芯片堆疊,每臺設備總容量為64 GB。

為了應對人工智能訓練、高性能計算(HPC)及其他高要求應用中遇到的內存瓶頸,業界一直熱切期待下一代HBM4內存的問世。JEDEC最近宣布了HBM4內存標準,為行業帶來了又一次重大飛躍。

JEDEC已就最高6.4 Gb/s的速度箱達成初步協議。此外,通過采用2048位寬的接口——是前幾代HBM的兩倍——相比HBM3初版,在相同數據率下內存帶寬翻倍,帶寬比HBM3e標準高出33%。這帶來了顯著加快的數據訪問和處理速度,使AI模型能夠比以往更高效地訓練和運行。

HBM4還集成了先進的可靠性、可用性和可維修性(RAS)功能。這在擁有數千GPU的大規模并行處理架構中尤為關鍵,因為硬件故障平均每隔幾小時就會發生一次。更高的可靠性對于確保穩定性能和最小化停機時間至關重要。

要充分發揮HBM4的強大性能,必須配備一個復雜的內存控制器。市場上領先的控制器支持JEDEC的6.4 Gb/s規范,并可與第三方或客戶PHY解決方案配合,構建完整的HBM4內存子系統。

實施HBM4面臨的挑戰

實施HBM4帶來了新的挑戰。一個主要障礙是以更高速度管理數據并行的復雜性。新的HBM4控制器采用了更復雜的重排邏輯。這優化了輸出HBM事務和輸入HBM讀取數據,保持高帶寬數據接口的高效利用且功耗可控。

另一個挑戰是熱管理。憑借更高性能,HBM內存控制器必須意識到熱點的潛在存在。下一代HBM4控制器通過提供機制來解決這個問題,使主機系統能夠讀取存儲芯片的熱狀態,從而在熱參數范圍內有效管理整個系統。

隨著生成式人工智能時代的展開,越來越復雜且數據需求極大的模型將會出現,內存帶寬的重要性不容忽視。實現下一代人工智能需要解鎖前所未有的HBM4內存性能及更高性能。芯片設計師敏銳地關注未來,正塑造人工智能革命的軌跡,賦能研究人員和開發者推動可能性的邊界。

評論