用大型語言模型構建讓我明白了一個明確的道理:最好的AI功能往往是隱形的。當它成功時,用戶不會停下來想“那是人工智能”。他們只需點擊一個按鈕,快速得到回復,然后繼續他們的任務。當它不奏效時,你會立刻注意到:轉盤花的時間太長,或者答案聽起來自信但其實不是真的。我多次遇到這兩堵墻。每次修復都不是關于“更智能的AI”,而是關于謹慎的工程選擇。只使用你需要的上下文。要求有結構化的產出。當準確性重要時,保持低隨機性。讓系統說“我不知道”。本指南不涉及大型研究理念。它講述的是任何工程師都可以遵循的實際步驟,將開源的大型

關鍵字:

AI LLM

實現FPGA加速LLM性能Speedster7t FPGA 在運行 Llama2 70B 參數模型時,與 GPU 解決方案相比表現如何?證據令人信服——Achronix Speedster7t FPGA 在處理大型語言模型(LLM)方面表現優異,通過提供計算能力、內存帶寬和卓越能效的最佳組合——這些是當今大型語言模型復雜需求的關鍵特質。像Llama2這樣的大型語言模型的快速發展,為自然語言處理(NLP)開辟了一條新的道路,有望帶來比以往任何時候都更接近人類的互動和理解。這些復雜的大型語言模型是創新的催化劑

關鍵字:

FPGA LLM

Cerence聲稱其人工智能驅動的對話式語音助手技術已向全球80多家汽車制造商和一級供應商提供服務。Cerence xUI在今年慕尼黑IAA Mobility 2025展會上向WardsAuto展示了其AI語音輔助如何直觀地與用戶對話。 許可由CerenceAI FAB電影廣告品牌授權與機器人助手對話過去只是《鋼鐵俠》電影中的一個場景,但現在許多現代汽車都配備了由語音服務專家Cerence提供的功能。該公司聲稱其AI驅動的對話語音助手已向全球80多家汽車制造商和一級供應商提供服務,約有5.25億輛汽車上路

關鍵字:

Cerence AI 語音助手 車載 AI 汽車 LLM 交互

摘要過去幾年,機器人技術突飛猛進,但“理解人類意圖、在非結構化環境中穩健執行”的核心能力仍顯不足。大型語言模型(LLM)被視為潛在的“語義大腦”,可將開放式自然語言映射為可執行的多步計劃,并在執行中進行自檢與糾錯,從而提升機器人在家庭、醫療與工業場景中的可用性。本文系統梳理 LLM+機器人(下稱 LLM-Robo)的最新工程思路、關鍵挑戰與代表性數據:能力側:從“代碼式精確指令”轉向“語言式開放交互”,支持迭代計劃與上下文感知。工程側:集成 LLM、控制系統與多模態傳感的完整鏈路仍復雜,涉及語義落地(gr

關鍵字:

機器人,LLM

當 GPT-4o 用毫秒級響應處理圖文混合指令、Gemini-1.5-Pro 以百萬 token 上下文 “消化” 長文檔時,行業的目光正從云端算力競賽轉向一個更實際的命題:如何讓智能 “落地”?—— 擺脫網絡依賴、保護本地隱私、控制硬件成本,讓設備真正具備 “看見并對話” 的離線智能,成為邊緣 AI 突破的核心卡點。2024 年,隨著邊緣 SoC 算力正式邁入 6 TOPS 門檻,瑞芯微 RK3576 給出了首個可量產的答案:一套完整的多模態交互對話解決方案。RK3576多模態純文字:自我介紹如今,“端

關鍵字:

瑞芯微 RK3576 NPU(神經網絡處理器) 端側小語言模型(SLM) 多模態 LLM 邊緣AI部署 開發板

隨著大語言模型(LLM)技術的快速迭代,從云端集中式部署到端側分布式運行的趨勢日益明顯。端側小型語言模型(SLM)憑借低延遲、高隱私性和離線可用的獨特優勢,正在智能設備、邊緣計算等場景中展現出巨大潛力。瑞芯微 RK3576 開發板作為一款聚焦邊緣 AI 的硬件平臺,其集成的 NPU(神經網絡處理器)能否高效支撐多模態 LLM 的本地運行?性能表現如何??RK3576 多模態純文字:愛因斯坦有什么貢獻RK3576 多模態純文字:自我介紹本文將圍繞這一核心問題展開 —— 從端側 SLM 與云端 LL

關鍵字:

瑞芯微 RK3576 NPU 端側小語言模型 SLM 多模態 LLM

如果您曾經參加過企業性格或技能評估,您可能遇到過 Core Values Finder,這是一種衡量個人價值觀的工具。它基于評估人類價值觀的最可靠和有效的工具之一:肖像價值觀問卷修訂版 (PVQ-RR)。科學問卷的目標是評估受訪者如何與 20 種不同的價值觀保持一致,其中包括關懷、寬容、謙遜、成就和自我指導。受訪者使用 1(“最不像我”)到 6(“最像我”)的等級進行排名。他們的回答表明了什么對他們來說很重要,以及什么影響了他們如何做出決策。我和我在 AI Alt Lab 的團隊研究

關鍵字:

LLM Google Meta OpenAI

大型語言模型 (LLM) 的早期歷史由 OpenAI 主導,在較小程度上由 Meta 主導。OpenAI 的早期 GPT 模型確立了 LLM 性能的前沿,而 Meta 則通過提供強大性能的開放權重模型開辟了一個健康的利基市場。開放權重模型具有可公開訪問的代碼,任何人都可以自由使用、修改和部署這些代碼。這使得包括谷歌在內的一些科技巨頭落后了。2017 年,谷歌發表了一篇關于支撐大型語言模型的 transformer 架構的突破性研究論文,但該公司往往因其在

關鍵字:

LLM Google Meta OpenAI

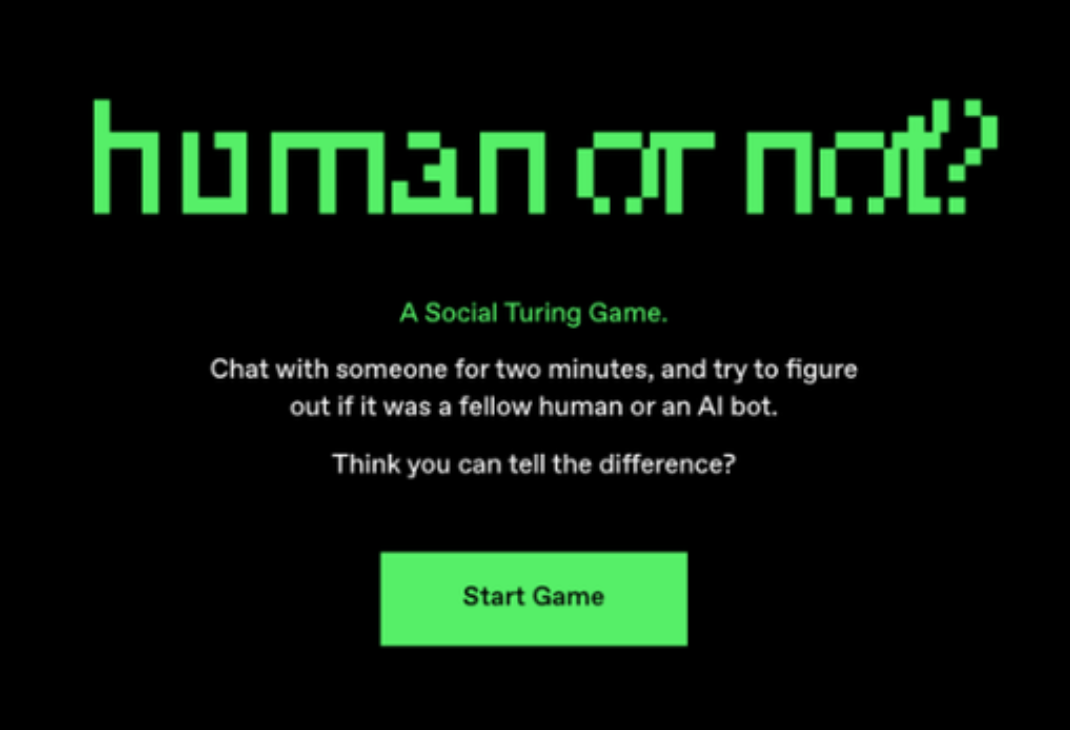

美國加州大學圣地亞哥分校(UCSD)發布了一項研究成果,宣稱首次提供了“人工智能系統能夠通過標準三方圖靈測試的實證證據”,證明大語言模型(LLM)通過了圖靈測試。其中,GPT-4.5被判斷為人類的比例高達73%,顯著高于真實人類參與者被選中的比例。圖靈測試由英國數學家和計算機科學家Alan Turing于1950年提出,他稱之為“模仿游戲”。圖靈設想,如果一名提問者在通過文本交流時無法區分對方是機器還是人類,那么這個機器可能具備類似人類的智能。在三方圖靈測試中,提問者需與一名人類和一臺機器進行對話,并準確

關鍵字:

大模型 圖靈測試 AI GPT LLaMa LLM

1? ?KG與LLM完美結合大語言模型(LLM)在各種應用領域中已經取得了顯著的成功,但是它常常無法捕捉和掌握最新的事實知識。而另一方面,知識圖(Knowledge Graph,簡稱:KG)則擁有豐富的專家知識和事實知識,但它很難以構建,又又不足以處理現實世界知識圖譜的動態變化性質和因果推論功能等。因此,自然而然地將KG 和LLM結合起來,各自發揮優勢,相輔相成,締造完美組合。2? ?KG協助LLM:降低LLM幻覺大家都知道,LLM 常有幻覺(Hallucinati

關鍵字:

202503 LLM 行業KG 知識圖

2月28日消息,美國時間周四,OpenAI宣布推出GPT-4.5,這是其最新、最強大的大語言模型(LLM)的研究預覽版,專為聊天應用設計。不過,這也是OpenAI迄今為止最昂貴的模型。不過,GPT-4.5仍然是一款傳統的大型語言模型,而非“推理模型”。此前,OpenAI、DeepSeek、Anthropic等公司都推出了推理模型,這些模型能夠生成“思維鏈”或類似意識流的文本,通過反思自身的假設和結論,嘗試在向用戶提供響應或輸出之前捕捉錯誤。盡管如此,OpenAI聯合創始人兼首席執行官山姆·奧特曼(Sam

關鍵字:

GPT-4.5 GPT-4 OpenAI LLM

作者:Arm 基礎設施事業部軟件工程師 Nobel Chowdary Mandepudi生成式人工智能 (AI) 正在科技領域發揮關鍵作用,許多企業已經開始將大語言模型 (LLM) 集成到云端和邊緣側的應用中。生成式 AI 的引入也使得許多框架和庫得以發展。其中,PyTorch 作為熱門的深度學習框架尤為突出,許多企業均會選擇其作為開發 AI 應用的庫。通過部署 Arm Kleidi 技術 ,Arm 正在努力優化 PyTorch,以加速在基于 Arm 架構的處理器上運行 LLM 的性能

關鍵字:

Arm KleidiAI PyTorch LLM

工業物聯網領域的全球供應商研華科技近日公布,其自主研發的“AIR-520本地大型語言模型(LLM)邊緣AI服務器”榮獲“第33屆臺灣精品獎”銀獎!今年,研華有六款產品獲得了中國臺灣精品獎,其中兩款獲得了享有盛譽的銀獎。這一出色的成績凸顯了業界對研華智能系統和嵌入式平臺在工業物聯網領域的認可。研華表示將繼續整合人工智能驅動的行業解決方案和領域專業知識,加速數字化轉型,為客戶推動工業智能的發展。研華嵌入式物聯網集團總經理張家豪強調,研華作為一家跨越邊緣計算、物聯網系統軟件和垂直行業解決方案的多元化工業物聯網企

關鍵字:

研華 本地大型語言模型 LLM 邊緣AI服務器

新聞重點:●? ?在Arm CPU上運行Meta最新Llama 3.2版本,其云端到邊緣側的性能均得到顯著提升,這為未來AI工作負載提供了強大支持●? ?Meta與Arm的合作加快了用例的創新速度,例如個性化的端側推薦以及日常任務自動化等●? ?Arm十年來始終積極投資AI領域,并廣泛開展開源合作,為?1B?至?90B?的?LLM?實現在?Arm?計算平臺上無縫運行人

關鍵字:

Arm Llama 3.2 LLM AI 推理 Meta

llm介紹

您好,目前還沒有人創建詞條llm!

歡迎您創建該詞條,闡述對llm的理解,并與今后在此搜索llm的朋友們分享。

創建詞條

關于我們 -

廣告服務 -

企業會員服務 -

網站地圖 -

聯系我們 -

征稿 -

友情鏈接 -

手機EEPW

Copyright ?2000-2015 ELECTRONIC ENGINEERING & PRODUCT WORLD. All rights reserved.

《電子產品世界》雜志社 版權所有 北京東曉國際技術信息咨詢有限公司

京ICP備12027778號-2 北京市公安局備案:1101082052 京公網安備11010802012473