硅谷AI權力的游戲開啟新支線

Gemini 3橫空出世,谷歌這家曾被認為在AI時代稍顯落后、有點沉睡的巨頭,正在全面覺醒。當奧特曼在深夜罕見地發推承認“OpenAI在某些關鍵維度上確實落后了”時,人們開始發現不用英偉達的芯片,只用TPU也能訓練出最頂級的AI模型。

Gemini 3的突破在于「天生」就是感官互通的,它理解一段視頻 —— 不同于之前的模型(包括GPT-4o)需要不同的神經網絡處理圖像和文本 —— 像人類一樣直接理解光影和動態,而不是翻譯成文字再理解。這不僅帶來了極致的低延遲,更讓它的「直覺」可怕地敏銳。

如果說Gemini 3打OpenAI還是AI技術之爭,那么讓英偉達緊張的,則是生存邏輯或將改變:Gemini 3是完全在谷歌自研的最新一代TPU(Tensor Processing Unit,TPU)集群上訓練出來的。英偉達依靠著CUDA生態以及GB 200芯片,建立了牢不可破的軟硬件壁壘,但是這道密不透風的鐵幕已經被谷歌用TPU撕開了一角,打破英偉達對高端AI芯片市場的絕對壟斷。

谷歌正在與Meta以及其他云服務客戶商談,允許他們在自己的數據中心使用其TPU芯片。據報道,Meta計劃在2027年將谷歌的TPU芯片引入Meta自己的數據中心,潛在交易規模或達數十億美元。值得注意的是,為了助力新推出的旨在讓其他客戶在其數據中心使用其人工智能芯片的計劃(名為“TPU@Premises”),谷歌開發了一款軟件,能夠在讓客戶更輕松地使用這些芯片。

這一計劃的核心極具顛覆性,谷歌不再強制客戶必須在谷歌云里使用TPU,而是允許客戶將這些算力怪獸直接搬進自家的數據中心,谷歌的一位高管透露TPU有望拿下英偉達10%的營收。

谷歌全面覺醒

在Gemini 3爆火后,谷歌的官方博客迅速跟進了一篇最新TPU的介紹帖子。Ironwood是谷歌迄今為止性能最強、能力最出眾且能效最高的TPU,專為大規模驅動推理型人工智能模型而設計,其單芯片在訓練與推理工作負載上的性能表現較上一代提升逾四倍。

在將浮點運算性能標準化到相同精度后,最新的谷歌Ironwood TPU v7與英偉達目前的旗艦Blackwell B200在性能非常接近。

· 在關鍵的FP8精度下,Ironwood TPU v7的峰值算力約為4.6PFLOPS,而英偉達B200為4.5PFLOPS。雖然略高于B200,但低于GB200/GB300的5PFLOPS。

· 兩者均配備了192GB的HBM3e高帶寬內存,提供7.4TB/s的帶寬,與英偉達的B20處于同一水平。對于受限于顯存容量的大模型訓練來說,谷歌并沒有讓英偉達拉開半個身位

· 對于芯片間通信,每個TPU具有四個ICI(芯片間互聯)鏈路,可提供9.6Tbps的總雙向帶寬,而英偉達B200/B300的帶寬為14.4Tbps。

谷歌真正的訣竅在于能夠將TPU擴展到真正龐大的計算域:Ironwood Pods可以通過芯片間互連網絡連接多達9216個獨立芯片,這種龐大的互連架構能夠共享1.77PB的高帶寬內存,谷歌在技術文檔中指出:“作為參考,這意味著Ironwood Pods的FP8 ExaFLOPS性能是其最接近的競爭對手的118倍”。

而英偉達的NVL72機架式系統則是利用其專有的NVLink互連技術,將72個最新的Blackwell加速器連接成一個單一的計算域。需要明確的是,包含數十萬個英偉達GPU的計算集群確實存在,而且實際上已經很常見,不同之處在于其機架級平臺選擇了一種大型、相對扁平的交換機拓撲結構。在Blackwell架構之前這些集群都是使用八路GPU單元構建的,并以大規模橫向擴展的方式排列,而谷歌擴展計算架構的方法與英偉達截然不同。

谷歌采用了一種3D環面拓撲結構,其中每個芯片都以三維網格的形式與其他芯片連接,這種拓撲結構無需使用高性能數據包交換機,而高性能數據包交換機價格昂貴、耗電量大,并且在高負載下可能會引入不必要的延遲。但網狀拓撲意味著任何一個芯片與其他芯片通信可能需要更多跳數,隨著環面規模的擴大,芯片間延遲的可能性也會增加。為此谷歌采用了光路交換技術,使其能夠將TPU模塊切割成各種形狀和尺寸,以便更好地適應其自身內部和客戶的工作負載:光路交換機(OCS)使用多種方法(例如MEMS器件)將一個TPU連接到另一個TPU,由于這種連接通常是通過物理方式將一個端口連接到另一個端口來實現的,因此幾乎不會引入延遲。

同時,OCS還有助于提高容錯能力,因為如果TPU發生故障,OCS設備可以將其從網絡中移除,并用正常工作的部件替換它。構成一個“動態可重構架構”,當個別組件發生故障或需要維護時,OCS技術會在幾毫秒內自動將數據流量繞過中斷點,從而使工作負載能夠繼續運行,而不會對用戶造成任何可見的干擾。谷歌報告稱,自2020年以來,其液冷系統的整體正常運行時間一直保持在約99.999%的可用性水平 —— 相當于每年停機時間不到6分鐘。

這意味著對于Meta這樣的客戶而言,選擇TPU不再是為了省錢而做的降級消費,而是一種真正的「平替」,甚至是在大規模集群效率上更優的選擇。很多人會問為什么是現在,谷歌之前在干嘛?其實兩年前的谷歌雖然有DeepMind和Google Brain兩個頂尖大腦,但內部內耗嚴重、資源分散;而在合并團隊后,谷歌終于打通了“任督二脈”。

另外,谷歌的聯合創始人謝爾蓋·布林(Sergey Brin)的回歸則帶來更加底層的影響,他回到谷歌后提交了多年來的第一個CL(Changelist,谷歌內部的代碼修改請求),對工程師內部產生了地震般的效應:如果身價千億的創始人都在修補配置文件,那么任何產品經理都沒有理由以“流程”為借口阻礙發布。布林的存在直接催化了Gemini 3項目的加速,他專注于解決模型在長邏輯鏈推理上的「長尾問題」,這是之前職業經理人們因追求短期指標而忽視的領域。

TPU v1于2015年在谷歌內部署,并于2016年的Google I/O大會上公開發布。它的誕生過程極不尋常,并非一個循序漸進的研發項目,更像是一項緊急的“救火”措施。谷歌在構建芯片的同時才開始招聘團隊,這表明該項目風險極高,但也具有最高優先級,TPU v1從設計、驗證、制造到部署至數據中心僅用了15個月。

除了TPU,谷歌是唯一一家全棧人工智能公司:數據→算法→硬件→云服務器。它使用自己的數據來訓練自己的算法;這些算法部署在自有云上的自研芯片上運行。

如果開發者無法輕松利用硬件性能,那么硬件性能就毫無意義,英偉達最深的護城河是CUDA軟件生態。谷歌深知這一點,因此它并沒有強推自己的JAX語言,而是擁抱了Meta發明的PyTorch。通過新開發的「TPU Command Center」軟件,谷歌正在讓開發者能夠像使用GPU一樣順滑地通過PyTorch調用TPU。

谷歌AI基金(Google AI Infrastructure Fund)便是在這種體系下自然誕生的產物,用以扶持所有基于谷歌云與TPU生態的AI公司,Anthropic、Cohere、Character.AI、Essential AI……這些獨立的創業公司在算力與模型底座上都深度綁定谷歌的TPU集群與Gemini模型家族。換句話說,谷歌的AI基金并非簡單的投資人,而是用資本作為粘合劑,將算力、云服務與生態綁定在一起。Anthropic是谷歌最大的客戶之一,已宣布計劃利用多達一百萬個TPU來訓練和運行其下一代Claude模型。

AI芯片不再是英偉達的獨角戲

Gemini 3的出現,標志著AI戰爭正式進入下半場。11月中旬,“股神”沃倫·巴菲特(Warren Buffett)的伯克希爾·哈撒韋公司披露了在三季度歷史首次持倉Alphabet,市值接近50億美元。Alphabet發布的三季報顯示營收首次突破千億美元,高達1550億美元的云業務訂單和超700億美元的自由現金流,尤其是在科技巨頭中最低的估值,都受到了市場重視。

目前AI股“王座”上的英偉達面臨的環境要惡劣得多,在谷歌的大模型和TPU芯片接連爆出好消息后,再次遭遇了唱空。當市場開始意識到TPU v7的性能足以比肩B200,當Meta這樣的巨頭開始嘗試「去英偉達化」,這場芯片戰爭就不再是英偉達的獨角戲了。

Melius Research的科技策略師本·賴茨斯(Ben Reitzes)分析稱,開發成本更低、能耗負擔更小的TPU芯片已經引發了不少英偉達投資者的焦慮,尤其在通過這一芯片訓練的Gemini大模型取得巨大進步,且其產品將廣泛進入市場的背景下,所有芯片企業和云計算公司都應對此保持警覺。

英偉達在社交媒體上官方表態“為谷歌的成功感到高興,將繼續為谷歌提供產品和服務”后,重點強調自己的產品領先業界一代,也是唯一一個可以運行所有AI模型、并在各種運算場景中通用的平臺。與專為特定AI框架或功能設計的ASIC相比(意指TPU),英偉達芯片提供了更高的性能、多功能性和可互換性。

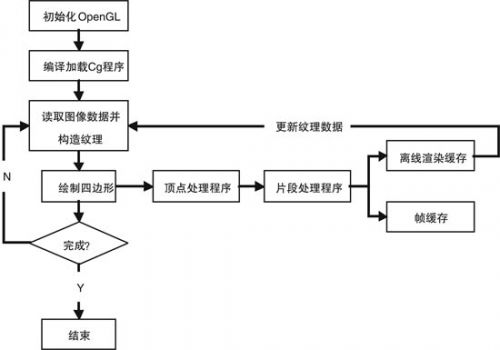

TPU和GPU技術在AI運算中的角色與定位截然不同。GPU最初是為了加速游戲圖像渲染與視覺特效而設計,強調大量平行處理能力;當機器學習興起時,業界發現GPU非常適合AI模型訓練所需的大規模運算,因而從一躍成為AI運算的主流芯片。TPU則屬于特定應用積體電路(ASIC),從研發之初便帶有單一目的,亦即專門用于加速神經網路運算中最核心的大規模矩陣乘法。

盡管英偉達首席執行官黃仁勛可能會淡化人工智能ASIC對其GPU帝國的威脅,但很難忽視這樣一個事實:谷歌、亞馬遜等公司的芯片在硬件能力和網絡可擴展性方面正在迅速趕上,而軟件往往最終成為決定性因素。雖然短期來看,英偉達在AI芯片領域的主導地位不會很快被動搖,目前在人工智能GPU領域的市占率仍有約九成,其最新的Rubin超級芯片也已蓄勢待發。

除了要拿下其年營收10%份額的谷歌,其芯片行業內的最大競爭對手AMD也明確表示,要在未來三到五年內,實現人工智能GPU市場“兩位數”的份額。另外,亞馬遜、OpenAI等也都在加碼自研芯片。Skagen AS投資總監亞歷山德拉?莫里斯(Alexandra Morris)近期就表示,英偉達仍然很出色,但那種認為只有這家公司能為數據中心提供芯片的看法已經一去不復返了。

不過值得注意的是,得益于高達73%的利潤率,英偉達今年的自由現金流預計將飆升至970億美元。根據外媒報道,英偉達準備通過向Meta注入巨額投資來換取其繼續使用英偉達芯片的承諾,這意味著英偉達正在試圖通過資本手段維護自己的“C位”。但是,如果最強的模型不需要英偉達的GPU就能跑出來,那么英偉達這么高的毛利率還能維持多久?

評論