InfiniBand 與以太網(wǎng):Broadcom 和 NVIDIA 橫向擴(kuò)展技術(shù)戰(zhàn)

以太網(wǎng)有望重新成為橫向擴(kuò)展數(shù)據(jù)中心的主流,而 InfiniBand 在 HPC 領(lǐng)域保持強(qiáng)勁勢(shì)頭。博通和英偉達(dá)正在爭(zhēng)奪主導(dǎo)地位。

隨著人工智能模型規(guī)模呈指數(shù)級(jí)增長(zhǎng),數(shù)據(jù)中心擴(kuò)展已從單系統(tǒng)縱向擴(kuò)展架構(gòu)轉(zhuǎn)變?yōu)樯婕皵?shù)萬個(gè)互連節(jié)點(diǎn)的橫向擴(kuò)展架構(gòu)。橫向擴(kuò)展網(wǎng)絡(luò)市場(chǎng)主要由兩種競(jìng)爭(zhēng)技術(shù)主導(dǎo):

InfiniBand:它被稱為性能領(lǐng)導(dǎo)者,由 NVIDIA 子公司 Mellanox 推動(dòng),利用原生 RDMA 協(xié)議提供極低的延遲(低于 2 微秒),并且零丟包風(fēng)險(xiǎn)。

以太網(wǎng):具有開放的生態(tài)系統(tǒng)和顯著的成本優(yōu)勢(shì),受到博通等主要參與者的擁護(hù)。

2025 年 6 月,隨著 Ultra Ethernet Consortium(UEC)發(fā)布 UEC 1.0,以太網(wǎng)發(fā)起了強(qiáng)勢(shì)反擊,UEC 1.0 是一種重構(gòu)網(wǎng)絡(luò)堆棧以實(shí)現(xiàn)類似 InfiniBand 性能的規(guī)范。憑借多重優(yōu)勢(shì),以太網(wǎng)有望逐步擴(kuò)大其市場(chǎng)份額。這種技術(shù)轉(zhuǎn)變正在重塑橫向擴(kuò)展市場(chǎng)的整個(gè)競(jìng)爭(zhēng)格局。

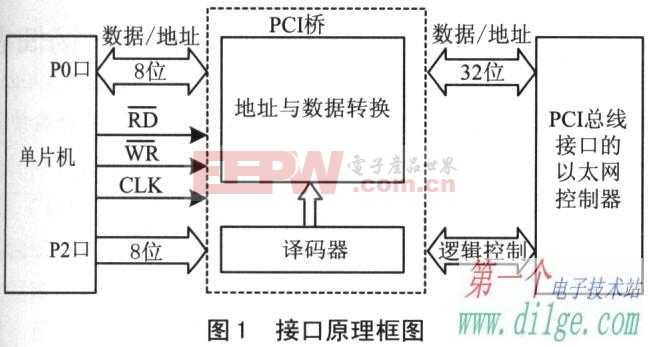

圖1

橫向擴(kuò)展的關(guān)鍵戰(zhàn)場(chǎng):InfiniBand 優(yōu)勢(shì)和以太網(wǎng)反擊

用于橫向擴(kuò)展的主流 InfiniBand 架構(gòu)本質(zhì)上支持遠(yuǎn)程直接內(nèi)存訪問 (RDMA),其作方式如下:

在數(shù)據(jù)傳輸過程中,DMA 控制器將數(shù)據(jù)發(fā)送到支持 RDMA 的網(wǎng)絡(luò)接口卡 (RNIC)。

RNIC 打包數(shù)據(jù)并直接傳輸?shù)浇邮?RNIC。

由于此過程繞過 CPU,與傳統(tǒng)的 TCP/IP 協(xié)議不同,InfiniBand 數(shù)據(jù)傳輸可以實(shí)現(xiàn)極低的延遲,低于 2 μs。

此外,InfiniBand 還具有鏈路層基于信用的流量控制 (CBFC) 機(jī)制,可確保僅在接收方有可用緩沖區(qū)空間時(shí)傳輸數(shù)據(jù),從而保證零丟包。

本機(jī) RDMA 協(xié)議需要 InfiniBand 交換機(jī)才能運(yùn)行。然而,InfiniBand 交換機(jī)長(zhǎng)期以來一直由 NVIDIA 的 Mellanox 主導(dǎo),使得生態(tài)系統(tǒng)相對(duì)封閉,采購(gòu)和維護(hù)成本較高;硬件成本約為以太網(wǎng)交換機(jī)的三倍。

表 1.InfiniBand 技術(shù)演進(jìn)

| 年 | 2011 | 2015 | 2017 | 2021 | 2024 | 2027 | 2030 |

|---|---|---|---|---|---|---|---|

| 數(shù)據(jù)速率 | FDR (十四數(shù)據(jù)速率) | EDR (增強(qiáng)數(shù)據(jù)速率) | HDR (高數(shù)據(jù)速率) | NDR (下一個(gè)數(shù)據(jù)速率) | XDR( 極限數(shù)據(jù)速率) | 東德 (E) | LDR (E) |

| 帶寬/端口(8 通道) | 109 Gbps | 200 Gbps | 400 Gbps | 800 Gbps | 1.6 Tbps | 3.2 Tbps | 6.4 Tbps |

| 帶寬/端口(4 通道) | 54.5 Gbps | 100 Gbps | 200 Gbps | 400 Gbps | 800 Gbps | 1.6 Tbps | 3.2 Tbps |

| 帶寬/通道 | 13.6 Gbps | 25 Gbps | 50 Gbps | 100 Gbps | 200 Gbps | 400 Gbps | 800 Gbps |

| 調(diào)制技術(shù) | NRZ | NRZ | NRZ | PAM4 | PAM4 | PAM6 (E) | PAM6 (E) |

注:(E)表示“估計(jì)”。

(來源:TrendForce集邦咨詢)

以太網(wǎng)因其開放的生態(tài)系統(tǒng)、多供應(yīng)商、靈活的部署和較低的硬件成本而逐漸受到關(guān)注。

為了將 RDMA 優(yōu)勢(shì)引入以太網(wǎng),IBTA(InfiniBand 貿(mào)易協(xié)會(huì))于 2010 年引入了基于融合以太網(wǎng) (RoCE) 的 RDMA。最初的 RoCE v1 僅在鏈路層添加了一個(gè)以太網(wǎng)標(biāo)頭,將通信限制在第 2 層子網(wǎng)內(nèi),并防止跨路由器或不同子網(wǎng)傳輸。

為了增強(qiáng)部署靈活性,IBTA 于 2014 年發(fā)布了 RoCE v2。它用 IP/UDP 標(biāo)頭取代了第 3 層網(wǎng)絡(luò)層中的 InfiniBand GRH(全局路由標(biāo)頭)。這一變化使得RoCE數(shù)據(jù)包能夠被標(biāo)準(zhǔn)的以太網(wǎng)交換機(jī)和路由器識(shí)別和轉(zhuǎn)發(fā),實(shí)現(xiàn)跨多個(gè)子網(wǎng)或路由器的傳輸,大大提高了部署靈活性。然而,RoCE v2 延遲仍然略高于原生 RDMA,約為 5 μs,并且需要額外的功能,例如 PFC 和 ECN,以降低丟包風(fēng)險(xiǎn)。

圖2

圖 2 突出顯示了 InfiniBand 和 RDMA 技術(shù)下開放式 RoCE 之間的關(guān)鍵比較:

InfiniBand 使用完全專有的封閉協(xié)議棧,實(shí)現(xiàn)最低延遲。

RoCE v1 模擬以太網(wǎng)上的 IB 架構(gòu),但只能在同一層 2 子網(wǎng)內(nèi)運(yùn)行。

RoCE v2 使用 IP 網(wǎng)絡(luò)層,支持跨子網(wǎng)通信,并提供與現(xiàn)有以太網(wǎng)數(shù)據(jù)中心基礎(chǔ)設(shè)施的最高兼容性。

表 2.以太網(wǎng)技術(shù)演進(jìn)

| 年 | 2016 | 2018 | 2019 | 2021 | 2023 | 2025 | 2027 |

|---|---|---|---|---|---|---|---|

| 單芯片總帶寬 | 3.2 Tbps | 6.4 Tbps | 12.8 Tbps | 25.6 Tbps | 51.2 Tbps | 102.4 Tbps | 204.8 Tbps |

| 單芯片端口數(shù) | 32 | 64 | 64 | 64 | 64 | 64 | 64 |

| 帶寬/端口 | 100 Gbps | 100 Gbps | 200 Gbps | 400 Gbps | 800 Gbps | 1.6 Tbps | 3.2 Tbps |

| 通道數(shù)/端口 | 4 | 4 | 4 | 4 | 8 | 8 | 8 |

| 帶寬/通道 | 25 Gbps | 25 Gbps | 50 Gbps | 100 Gbps | 100 Gbps | 200 Gbps | 400 Gbps |

| 調(diào)制 | NRZ | NRZ | NRZ | PAM4 | PAM4 | PAM4 | PAM6 (E) |

注:(E)表示“估計(jì)”。

(來源:TrendForce集邦咨詢)

綜上所述,InfiniBand 具有極低延遲和零丟包等原生優(yōu)勢(shì),這就是為什么它在當(dāng)今的 AI 數(shù)據(jù)中心中仍然被廣泛采用;然而,它具有更高的硬件和維護(hù)成本以及有限的供應(yīng)商選擇。相比之下,在以太網(wǎng)上使用 RoCE v2 并不能實(shí)現(xiàn)與 InfiniBand 相同的性能,但它提供了一個(gè)開放的生態(tài)系統(tǒng)并降低了硬件和維護(hù)成本,促使逐漸轉(zhuǎn)向以太網(wǎng)架構(gòu)。

表 3.人工智能數(shù)據(jù)中心網(wǎng)絡(luò)的關(guān)鍵技術(shù)比較:InfiniBand 與以太網(wǎng)

| 協(xié)議 | InfiniBand (RDMA) | 以太網(wǎng) (RoCE v2) |

|---|---|---|

| 延遲 | <2 微秒 | <5 微秒 |

| 當(dāng)前主流帶寬/端口 | 800 Gbps | 800 Gbps |

| 無損機(jī)制 | 基于信用的流量控制 (CBFC) | 以太網(wǎng)流量控制 (802.3x)、PFC、ECN |

| 生態(tài)系統(tǒng) | 封閉式 (NVIDIA) | 打開 |

| 硬件成本 | 高 (1x) | 低 (1/3) |

(來源:TrendForce集邦咨詢)

目前,AI數(shù)據(jù)中心需求擴(kuò)張,結(jié)合成本和生態(tài)系統(tǒng)的考慮,促使英偉達(dá)進(jìn)入以太網(wǎng)市場(chǎng)。除了自己的 InfiniBand Switch Quantum 系列外,NVIDIA 目前還提供 Spectrum 系列下的以太網(wǎng)產(chǎn)品。

今年,Quantum-X800 可以在 144 個(gè)端口×提供 800 Gbps/端口,總計(jì) 115.2 Tbps;Spectrum-X800 可以在 64 個(gè)端口×提供 800 Gbps/端口,總計(jì) 51.2 Tbps。Quantum-X800 和 Spectrum-X800 的 CPO(共封裝光學(xué))版本預(yù)計(jì)分別于 2H25 和 2H26 推出。

雖然Spectrum的價(jià)格高于其他廠商的以太網(wǎng)交換機(jī),但英偉達(dá)的優(yōu)勢(shì)在于與硬件和軟件的深度集成,例如與BlueField-3 DPU和DOCA 2.0平臺(tái)配對(duì),實(shí)現(xiàn)高效的自適應(yīng)路由。

交換機(jī) IC 成本和 CPO 部署競(jìng)賽:以太網(wǎng)領(lǐng)先,InfiniBand 緊隨其后

在以太網(wǎng)領(lǐng)域,博通仍然是以太網(wǎng)交換機(jī)的技術(shù)領(lǐng)導(dǎo)者。其 Tomahawk 系列 Switch IC 遵循“每?jī)赡晔箍値挿环钡脑瓌t。到2025年,博通推出了全球總帶寬最高的交換機(jī)IC戰(zhàn)斧6,總帶寬為102.4 Tbps,支持1.6 Tbps/端口×64個(gè)端口。此外,Tomahawk 6 還支持 ultra UEC 1.0 協(xié)議,支持多路徑數(shù)據(jù)包噴涂、LLR 和 CBFC 等功能,進(jìn)一步降低延遲和丟包風(fēng)險(xiǎn)。

博通在 CPO 技術(shù)方面也處于領(lǐng)先地位。自 2022 年以來,它發(fā)布了 CPO 版本的戰(zhàn)斧 4 洪堡,隨后于 2024 年發(fā)布了戰(zhàn)斧 5 拜利,并在 2025 年繼續(xù)發(fā)布戰(zhàn)斧 6 戴維森,鞏固了其在以太網(wǎng)硬件集成方面的領(lǐng)先地位。

表 4.橫向擴(kuò)展交換機(jī) IC 比較:Broadcom、NVIDIA、Marvell、Cisco

| 供應(yīng)商 | 博通 | 英偉達(dá) | Marvell | 思科 | |||||

|---|---|---|---|---|---|---|---|---|---|

| 產(chǎn)品 | 戰(zhàn)斧5 | 戰(zhàn)斧6 | 戰(zhàn)斧 6 (CPO) | 量子-3 | 量子 3 (CPO) | 光譜-4 | 頻譜 4 (CPO) | 特拉林克斯 10 | 思科硅一號(hào) G200 |

| 發(fā)行年份 | 2023 | 2025 | 2025 | 2024 | 2025 | 2024 | 2026 | 2024 | 2023 |

| 處理節(jié)點(diǎn) | N5 | N3 | N3 | N4 | N4 | N4 | N4 | N5 | N5 |

| 單芯片帶寬 | 51.2 Tbps | 102.4 Tbps | 102.4 Tbps | 28.8 Tbps | 28.8 Tbps | 51.2 Tbps | 102.4 Tbps | 51.2 Tbps | 51.2 Tbps |

(來源:TrendForce集邦咨詢)

與今年首次推出 102.4 Tbps 戰(zhàn)斧 6 的博通相比,英偉達(dá)預(yù)計(jì)僅在 102.4 年下半年發(fā)布 1600 Tbps Spectrum-X2026,使其技術(shù)落后博通大約一年。

關(guān)于CPO,英偉達(dá)也有望在2026年下半年推出102.4 Tbps Spectrum-X Photonics的CPO版本,旨在追趕博通。

表 5.NVIDIA 橫向擴(kuò)展網(wǎng)絡(luò)開發(fā)路線圖

| 時(shí)間 | 1H25 | 2小時(shí)25分 | 2小時(shí)26分 | 2小時(shí)27分 | 2028 |

|---|---|---|---|---|---|

| 平臺(tái) | 布萊克威爾 | 布萊克威爾超 | 魯賓 | 魯賓超 | 費(fèi)曼 |

| InfiniBand 交換機(jī) | |||||

| 開關(guān) | 量子-2 | 量子-X800 | 量子-X1600 | 量子-X3200 | |

| 總帶寬 | 51.2 Tbps | 115.2 Tbps | 230.4 Tbps | - | |

| 帶寬/端口 | 400 Gbps | 800 Gbps | 1.6 Tbps | 3.2 Tbps | |

| 以太網(wǎng)交換機(jī) | |||||

| 開關(guān) | 光譜-X800 | 光譜-X1600 | 光譜-X3200 | ||

| 總帶寬 | 51.2 Tbps | 102.4 Tbps | 204.8 Tbps | ||

| 帶寬/端口 | 800 Gbps | 1.6 Tbps | 3.2 Tbps | ||

| 網(wǎng)絡(luò)接口卡 (NIC) | |||||

| 超級(jí)網(wǎng)卡 | 連接X-8 | 連接X-9 | 連接X-10 | ||

| 帶寬/端口 | 800 Gbps | 1.6 Tbps | 3.2 Tbps | ||

| 帶寬/通道 | 200 Gbps | 200 Gbps | 400 Gbps | ||

| PCIe 規(guī)格 | PCIe 6.0(48 通道) | PCIe 7.0(48 通道) | PCIe 8.0 接口 | ||

(來源:TrendForce集邦咨詢)

除了博通和英偉達(dá)陣營(yíng),其他廠商也加入了競(jìng)爭(zhēng)。Marvell 于 10 年推出了總帶寬為 51.2 Tbps 的 Teralynx 2023,思科還在 200 年發(fā)布了總帶寬為 51.2 Tbps 的 Cisco Silicon One G2023 系列及其 CPO 原型。

電氣通信達(dá)到極限,光集成成為焦點(diǎn)

傳統(tǒng)的數(shù)據(jù)傳輸主要依賴銅基電氣通信。然而,隨著傳輸距離要求的增加,光纖光通信在橫向擴(kuò)展場(chǎng)景中逐漸顯現(xiàn)出優(yōu)勢(shì)。與電通信相比,光通信具有低損耗、高帶寬、抗電磁干擾、遠(yuǎn)距離傳輸?shù)忍攸c(diǎn),如表6所示。

表 6.電氣和光通信架構(gòu)的比較

| 科技 | 電氣通信 | 光通信 |

|---|---|---|

| 中等 | 銅 | 纖維 |

| 主傳輸速率 | 56–112 Gbps | 200 Gbps |

| 互連距離 | ≤100 m(受傳輸速度影響的距離) | MMF (SR):50–100 m SMF (DR/FR):500 m–2 km SMF (LR/ER/ZR):10–80+ km |

| 功耗 | 高頻高 | 組件成本高,但可以通過封裝集成降低總功率 |

| 穩(wěn)定性 | 易受電磁干擾 | 不受電磁干擾 |

| 成本 | 成本最低,短距離連接簡(jiǎn)單 | 初始成本更高,但距離/密度可擴(kuò)展性更好 |

來源:TrendForce集邦咨詢

目前,光通信主要使用可插拔光收發(fā)器進(jìn)行光電信號(hào)轉(zhuǎn)換。傳輸速度達(dá)到每通道 200 Gbps,總帶寬高達(dá) 1.6 Tbps(8 × 200 Gbps)。

隨著速度的提高,功耗增加,電路板上的信號(hào)丟失變得更加明顯。硅光子學(xué) (SiPh) 技術(shù)是專門為解決這些問題而開發(fā)的。

硅光子學(xué)將小型化收發(fā)器組件集成到硅芯片中,形成光子集成電路(PIC),如下所示。PIC 進(jìn)一步封裝在芯片內(nèi),縮短了電氣距離并用光路取代了它們。這種封裝方法稱為共封裝光學(xué)器件 (CPO)。

圖3

CPO 的更廣泛概念如圖 4 所示,包括多種封裝形式,包括 OBO(板載光學(xué)器件)、CPO 和 OIO(光學(xué) I/O)。

圖4

圖 4 表明,光學(xué)引擎 (OE) 的封裝逐漸靠近主 ASIC。演化細(xì)節(jié)如下:

OBO:將 OE 封裝在 PCB 上,這在今天不太常用。

窄CPO:將OE封裝在基板上,這是目前主流的解決方案。與可插拔模塊相比,功耗降低至 <0.5× (~5 pJ/位),延遲降低至 <0.1× (~10 ns)。

OIO:將OE封裝在內(nèi)插層上,代表未來的方向。與可插拔模塊相比,功耗降低至 <0.1× (<1 pJ/bit),延遲降低至 <0.05× (~5 ns)。

然而,CPO仍面臨熱管理、鍵合、耦合等技術(shù)挑戰(zhàn)。隨著光通信接近極限,CPO 和硅光子學(xué)的突破將決定橫向擴(kuò)展網(wǎng)絡(luò)的下一個(gè)戰(zhàn)場(chǎng)。

以太網(wǎng)營(yíng)地集結(jié):UEC推廣UEC 1.0標(biāo)準(zhǔn)

如前所述,InfiniBand 的極低延遲使其在生成式人工智能開發(fā)的早期階段占據(jù)了重要的市場(chǎng)份額。然而,以太網(wǎng)作為主流的高性能網(wǎng)絡(luò)生態(tài)系統(tǒng)之一,也旨在實(shí)現(xiàn)極低的延遲。2023 年 8 月,超級(jí)以太網(wǎng)聯(lián)盟 (UEC) 成立,初始成員包括 AMD、Arista、Broadcom、Cisco、Eviden、HPE、Intel、Meta 和 Microsoft。

與 NVIDIA 主導(dǎo)的 InfiniBand 生態(tài)系統(tǒng)相比,UEC 強(qiáng)調(diào)開放標(biāo)準(zhǔn)和互作性,以避免依賴單一供應(yīng)商。

2025 年 6 月,UEC 發(fā)布了 UEC 1.0,這不僅僅是基于 RoCE v2 的改進(jìn),而是對(duì)軟件、傳輸、網(wǎng)絡(luò)、鏈路和物理等所有層的全面重建。

圖5

減少延遲的一個(gè)關(guān)鍵修改是在傳輸層增加了數(shù)據(jù)包傳輸子層 (PDS) 功能。其主要特點(diǎn)包括:

使用多路徑傳輸,其中端點(diǎn)之間存在多個(gè)等距且速度相等的路徑(軌道/車道)。

NIC 使用熵值將數(shù)據(jù)包分布到所有通道,從而允許并行傳輸以實(shí)現(xiàn)更大的帶寬。

這種多層結(jié)構(gòu)可以加速網(wǎng)絡(luò)恢復(fù),例如快速替換丟失的數(shù)據(jù)包以確保流量流暢,近似 InfiniBand 的自適應(yīng)路由。

另一方面,為了降低數(shù)據(jù)包丟失的風(fēng)險(xiǎn),UEC 1.0 引入了兩個(gè)主要變化:

鏈路層可選的鏈路層重試 (LLR) 功能,允許本地鏈路在數(shù)據(jù)包丟失時(shí)快速請(qǐng)求重傳,從而減少對(duì)優(yōu)先級(jí)流控制 (PFC) 機(jī)制的依賴。

鏈路層的可選基于信用的流控制 (CBFC) 功能,發(fā)送方必須在傳輸數(shù)據(jù)之前從接收方獲取信用。接收方在處理和釋放緩沖區(qū)空間后返回新的積分,實(shí)現(xiàn)無丟包風(fēng)險(xiǎn)的流量控制,類似于 InfiniBand 的 CBFC。

中國(guó)的橫向擴(kuò)展:協(xié)調(diào)標(biāo)準(zhǔn)和自主研發(fā)技術(shù)

中國(guó)的人工智能基礎(chǔ)設(shè)施橫向擴(kuò)展架構(gòu)正在沿著自主和國(guó)際兼容的原則發(fā)展。在堅(jiān)持國(guó)際以太網(wǎng)標(biāo)準(zhǔn)的同時(shí),國(guó)內(nèi)各大企業(yè)都在積極投入專有架構(gòu),逐步形成具有本土特色的橫向擴(kuò)展體系。

阿里巴巴、百度、華為、騰訊等科技大公司都選擇加入U(xiǎn)EC,共同推進(jìn)UEC標(biāo)準(zhǔn)的發(fā)展。除了參與標(biāo)準(zhǔn)化,中國(guó)企業(yè)還在自主研發(fā)專有的橫向擴(kuò)展架構(gòu),一般以低延遲和零丟包為目標(biāo),直接對(duì)標(biāo)InfiniBand。

表7.中國(guó)橫向擴(kuò)展和UEC架構(gòu)對(duì)比

| 協(xié)議 | UEC 1.0 | GSE 2.0(中國(guó)移動(dòng)) | HPN 7.0(阿里云) | UB 1.0(華為) |

|---|---|---|---|---|

| 延遲 | <2us | <2us | <2us | <2us |

| 主帶寬 | 800 Gbps | 800 Gbps | 400 Gbps | 400 Gbps |

| 丟包機(jī)制 | 鏈路層重試 (LLR)、基于信用的流控制 (CBFC) | DGSQ 流量控制 | Solar-RDMA,雙平面流量分配 | 鏈路層重試 (LLR) |

| 生態(tài)系統(tǒng) | 打開 | 打開 | 打開 | 閉 |

來源:TrendForce集邦咨詢

這些專有技術(shù)架構(gòu)的具體細(xì)節(jié)如下:

中國(guó)移動(dòng):通用調(diào)度以太網(wǎng)(GSE)中國(guó)

移動(dòng)于 2023 年 5 月在 UEC 架構(gòu)之前引入了 GSE。它分為兩個(gè)階段:GSE 1.0通過端口級(jí)負(fù)載均衡和端點(diǎn)網(wǎng)絡(luò)擁塞感知,優(yōu)化現(xiàn)有RoCE網(wǎng)絡(luò),提高數(shù)據(jù)傳輸穩(wěn)定性和整體性能,同時(shí)減少計(jì)算浪費(fèi)。

GSE 2.0 是一個(gè)完整的網(wǎng)絡(luò)重建,重新建立了從控制層、傳輸層到計(jì)算層的協(xié)議。它實(shí)現(xiàn)了多路徑噴涂和流量控制機(jī)制 (DGSQ),以更有效地分配流量,進(jìn)一步減少延遲和數(shù)據(jù)包丟失,以滿足未來 AI 計(jì)算中心的高性能需求。

阿里云:高性能網(wǎng)絡(luò)(HPN)

阿里云的 HPN 7.0 架構(gòu)采用“雙上行 + 多通道 + 雙平面”設(shè)計(jì)。雙上行提高網(wǎng)絡(luò)性能,多通道實(shí)現(xiàn)并行數(shù)據(jù)包傳輸,雙平面增強(qiáng)穩(wěn)定性。下一代 HPN 8.0 計(jì)劃采用完全專有的硬件,例如實(shí)現(xiàn) 800 Gbps 帶寬的 102.4 Tbps 交換機(jī) IC,對(duì)標(biāo)國(guó)際解決方案。華為:UB-Mesh互聯(lián)架構(gòu)

華為在昇騰NPU平臺(tái)上部署了專有的UB-Mesh架構(gòu),采用多維nD-Full Mesh拓?fù)浣Y(jié)構(gòu)。它支持橫向縱向擴(kuò)展和垂直擴(kuò)展。擴(kuò)展到三維以上,達(dá)到Scale-Out級(jí)別,能夠支持超大型AI訓(xùn)練集群。

中國(guó)專有的橫向擴(kuò)展架構(gòu)不斷發(fā)展,有望為本土企業(yè)提供更大的增長(zhǎng)機(jī)會(huì)。在中興旭創(chuàng)、光訊科技等企業(yè)的參與下,國(guó)產(chǎn)光模塊和硅光子技術(shù)有望形成完整的產(chǎn)業(yè)鏈,推動(dòng)AI基礎(chǔ)設(shè)施網(wǎng)絡(luò)化獨(dú)具中國(guó)特色的路徑。

下一代人工智能數(shù)據(jù)中心:技術(shù)轉(zhuǎn)型和機(jī)遇

長(zhǎng)期以來,英偉達(dá)的InfiniBand憑借其超低延遲(低于2μs)和零丟包能力,在AI數(shù)據(jù)中心的橫向擴(kuò)展市場(chǎng)占據(jù)主導(dǎo)地位。然而,隨著 2025 年 6 月 UEC 1.0 標(biāo)準(zhǔn)的發(fā)布,以太網(wǎng)網(wǎng)絡(luò)正在努力與 InfiniBand 的低延遲和高穩(wěn)定性相匹配,逐漸重新獲得市場(chǎng)競(jìng)爭(zhēng)力。同時(shí),博通始終如一的開發(fā)周期,每?jī)赡陮⒔粨Q機(jī) IC 帶寬翻一番,繼續(xù)推進(jìn)以太網(wǎng)硬件能力。

隨著傳輸速率達(dá)到1.6 Tbps或更高,傳統(tǒng)可插拔光模塊的功耗和延遲成為瓶頸,使得共封裝光學(xué)(CPO)技術(shù)在高性能網(wǎng)絡(luò)中日益成為標(biāo)準(zhǔn)。CPO 將光收發(fā)器直接集成到開關(guān)芯片基板上,顯著降低功耗和延遲。博通在 CPO 技術(shù)方面處于領(lǐng)先地位,自 2022 年以來推出了多代基于 CPO 的交換機(jī)。英偉達(dá)還計(jì)劃在2025年下半年發(fā)布InfiniBand CPO產(chǎn)品,預(yù)示著CPO將逐漸成為網(wǎng)絡(luò)架構(gòu)的主流。

隨著以太網(wǎng)和CPO技術(shù)的成熟,AI數(shù)據(jù)中心網(wǎng)絡(luò)正在全面向高速光通信邁進(jìn),為光收發(fā)模塊和上游供應(yīng)鏈創(chuàng)造新的增長(zhǎng)機(jī)會(huì),包括硅光子芯片、激光源和光纖模塊。

在橫向擴(kuò)展架構(gòu)中,NVIDIA 有望繼續(xù)引領(lǐng)傳統(tǒng)的 InfiniBand 市場(chǎng)。在以太網(wǎng)領(lǐng)域,博通預(yù)計(jì)將通過其領(lǐng)先的高帶寬交換機(jī) IC、CPO 技術(shù)和 UEC 標(biāo)準(zhǔn)的實(shí)施保持主要市場(chǎng)份額。

2025 年 8 月,NVIDIA 和 Broadcom 同時(shí)推出了 Scale-Across 概念,旨在將連接擴(kuò)展到多個(gè)數(shù)據(jù)中心。這種方法將實(shí)現(xiàn)更大規(guī)模的 GPU 互連和更遠(yuǎn)距離的傳輸,推動(dòng)高性能網(wǎng)絡(luò)和數(shù)據(jù)中心架構(gòu)的新范式。

評(píng)論