人工智能最大的瓶頸并非GPU,而是數據韌性

三年前,當鄧白氏集團(Dun & Bradstreet Holdings Inc.)著手構建一套以人工智能為核心的分析能力套件時,遭遇了一個如今在企業人工智能領域普遍存在的問題:如何在擴大人工智能工作流規模的同時,不犧牲對底層數據的信任。

信任是不容妥協的關鍵。該公司的全球企業識別編碼系統(Data Universal Numbering System),相當于企業的 “社會保障號”,已嵌入超過 20 萬家客戶的信貸決策、合規管理、貸款發放和供應商資質審核流程中,其中包括約 90% 的《財富》500 強企業。

鄧白氏首席數據與分析官加里?科托維茨(Gary Kotovets)表示,引入智能體人工智能(agentic AI)帶來了新的透明度、數據溯源和可恢復性挑戰,需要額外的保障措施。“我們業務的核心是信任,” 他說,“當我們開始通過人工智能和智能體提供這些數據時,必須確保同樣水平的信任得以延續。”

在兩年多的時間里,鄧白氏構建了一個多層數據韌性框架,包括統一的備份和留存策略、模型版本控制、置信度評分,以及用于檢測異常和合成輸出的完整性監控。該公司還擴展了治理層,以防止數據泄露,并執行嚴格的訪問權限規則。

鄧白氏科托維茨:“我們業務的核心是信任。”

“我們最初制定的治理標準以為能涵蓋所有情況,但在過去兩三年里一直在不斷補充完善,” 科托維茨說。當鄧白氏人工智能平臺(D&B.AI)推出時,信任已不僅僅是營銷口號,更是該系統可量化的屬性。

鄧白氏的經歷凸顯了企業必須付出的努力,以確保人工智能(尤其是智能體人工智能)能夠持續交付可靠可信的結果。近期研究表明,許多公司距離實現這一目標仍有很大差距。

在企業競相滿足董事會提出的人工智能應用需求時,支撐人工智能模型可靠運行的數據韌性基礎往往被忽視。這不僅帶來了新的網絡安全漏洞,若信任受損,還可能減緩人工智能的長期應用進程。

安全斷層

theCUBE Research 的一項新研究發現,盡管大多數組織認為自己在備受推崇的美國國家標準與技術研究院(NIST)網絡安全框架下表現強勁,但僅有 12% 的組織表示在遭受攻擊后能夠恢復所有數據,34% 的組織在過去一年中經歷了超過 30% 的數據丟失。

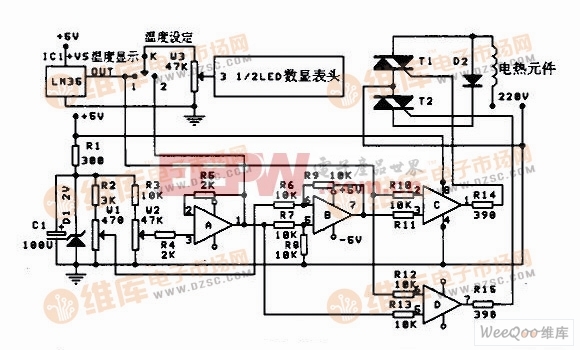

受可靠數據恢復系統保護的關鍵應用比例

(數據來源:theCUBE Research)

超過 80%:無具體占比數據

51%-80%:無具體占比數據

31%-50%:無具體占比數據

不足 30%:無具體占比數據

數據韌性(即保護、維護數據并從中斷中恢復數據的能力)方面的這些差距,正被人工智能模型對數據的海量需求進一步放大。許多專家表示,企業急于從多年來基本無法訪問的數據中挖掘洞察,因此構建了大規模的非結構化信息庫,卻未充分關注安全、訪問控制、備份和分類。人工智能模型的 “黑箱” 特性,使得治理不善的數據容易引發虛假信息、數據泄露和篡改問題。

“如果基礎數據一團糟,又如何能開展智能體人工智能應用?”theCUBE Research 負責網絡韌性、數據保護和數據管理的首席分析師克里斯托夫?伯特蘭(Christophe Bertrand)問道。硅谷角度(SiliconANGLE)旗下的市場研究公司將于 2 月 26 日舉辦人工智能信任與網絡韌性峰會,屆時將有行業專家、供應商和用戶參與。

盡管人們普遍認為人工智能需要高質量、治理良好的數據,但研究表明,人工智能推理數據的治理往往不完善、分類不充分,且很少進行備份。根據 theCUBE Research 的數據,僅有 11% 的受訪者備份了超過 75% 的人工智能數據,54% 的受訪者備份比例不足 40%。

48% 的受訪者表示,不足一半的關鍵應用受到全面數據恢復解決方案的保護,而僅有 4% 的受訪者表示超過 90% 的關鍵應用得到了完全保護。

智能體的放大效應

隨著智能體人工智能進入主流,數據韌性不足的風險將被進一步放大。生成式人工智能應用會像搜索引擎一樣,根據提示給出答案,而智能體系統則融入生產工作流,模型之間相互調用、交換數據、觸發操作,并在網絡中傳遞決策。錯誤數據在智能體之間流轉時,可能會像傳話游戲一樣被放大或篡改。

Countly 公司索納:“人工智能會放大薄弱的數據管道問題”

其他研究也發現了類似的信心差距。德勤(Deloitte LLP)近期開展的《企業人工智能現狀調查》涵蓋了 3000 多名企業和信息技術領導者,結果顯示,74% 的受訪者計劃在兩年內使用智能體人工智能,但僅有 21% 的受訪者針對自主智能體制定了成熟的治理流程。

去年秋天,信任管理平臺 Vanta Inc. 對 3500 名信息技術和業務領導者進行的調查發現,盡管 79% 的受訪者正在使用或計劃使用人工智能智能體防范網絡攻擊,但 65% 的受訪者表示其計劃使用規模超過了對該技術的理解程度。

高德納(Gartner Inc.)上月發布的一份報告指出,盡管高管和首席信息安全官(CISO)“都聲稱重視網絡韌性,但由于組織慣性和過時的‘零失敗容忍’思維模式,企業長期在這方面投資不足”。高德納表示,企業在 NIST 框架中關鍵的響應和恢復階段表現最差。

這些問題共同構成了一個迫在眉睫的信任危機。董事會和首席信息官一致認為,沒有高質量、具備韌性的數據,人工智能就無法大規模部署。然而在許多企業中,用于為人工智能引擎提供支持的推理數據治理不善、分類不一致且很少備份。這使得人們幾乎無法驗證決策的制定過程,也無法重現和消除下游影響。

企業人工智能應用的障礙,最終可能不在于模型準確性或處理能力供應,而在于能否保證人工智能所依賴數據的完整性、可追溯性和可恢復性。

“人工智能不會暴露薄弱的數據管道,” 分析公司 Countly Ltd. 的首席執行官奧努爾?阿爾普?索納(Onur Alp Soner)說,“它會放大這些問題。”

合規≠韌性

專家指出,許多企業忽視數據保護的原因有很多。關鍵原因之一是過度關注合規性,而犧牲了運營卓越性。這正是滿足一系列正式網絡安全指標與能夠在現實世界中斷中生存下來的區別。

合規指南規定了政策、控制措施和審計要求,而韌性則關乎運營生存能力,例如維護數據完整性、恢復完整業務運營、重現或回滾操作,以及在系統故障或遭受攻擊時控制影響范圍。

Info-Tech 公司阿瓦基安:“勾選框式合規” 會產生虛假的信心感。

企業往往將兩者混為一談,但制定計劃與在現實條件下測試計劃是兩回事。“他們會將 NIST 視為控制框架,然后說‘好的,我們有相關政策’,”Info-Tech Research Group Inc. 技術顧問、賓夕法尼亞州前首席信息安全官埃里克?阿瓦基安(Erik Avakian)說,“他們可能確實有政策,但從未對其進行過評估。”

他表示,“勾選框式合規” 會產生 “虛假的信心感”。“我們真的深入測試過這些政策嗎?它們真的有效嗎?有些框架只是無需實施證明的自我評估,” 這使得首席信息安全官可以實際上為自己的工作打分。

另一個因素是,網絡安全傳統上側重于防范入侵,而非控制損害。高德納指出,這種策略已變得 “成本過高且不切實際”。其研究人員轉而建議 “一種新的思維方式,將網絡韌性置于優先地位,并減輕不可避免的漏洞造成的損害”。

別人的問題

組織因素也會帶來漏洞。數據保護通常屬于風險管理職能范疇,與網絡安全相互獨立。安全專業人員可能會因為認為別人在負責數據保護而產生虛假的自滿情緒。

“企業內部由不同團隊負責韌性和合規導向的安全工作,導致協調不足,” 福雷斯特研究公司(Forrester Research Inc.)首席分析師布倫特?埃利斯(Brent Ellis)說,“人們認為自己做好的準備與實際準備情況之間存在脫節。”

福雷斯特公司埃利斯:“人們認為自己做好的準備與實際準備情況之間存在脫節。”

此外還有技術因素。人工智能模型的行為與傳統軟件有著本質區別,帶來了傳統數據保護措施無法完全解決的復雜性。

傳統軟件是確定性的,意味著它遵循預定義規則,確保相同的輸入始終產生相同的輸出。而人工智能模型是概率性的,它們利用統計或習得的估算過程,從訓練數據的模式中推斷出合理的輸出。

“對于解釋性或生成式人工智能,你是在讓引擎開始‘思考’,這會使其突破限制,以前所未有的方式整合內部和外部數據源,” 國際數據公司(International Data Corp.)全球基礎設施研究集團副總裁兼總經理阿希什?納德卡尼(Ashish Nadkarni)說。

概率性模型無法保證每次都產生相同的結果。確定性系統會通過生成錯誤來明確表示故障,而人工智能系統則會通過輸出看似可信但實際錯誤的結果來 “靜默故障”。

偏離目標

缺失或損壞的數據可能導致模型做出看似合理但實際上完全偏離目標的決策或建議。在大型語言模型中,這些錯誤表現為 “幻覺”—— 盡管經過多年研究試圖將其最小化,但在許多最受歡迎的聊天引擎中,“幻覺” 發生率仍高達 20%。

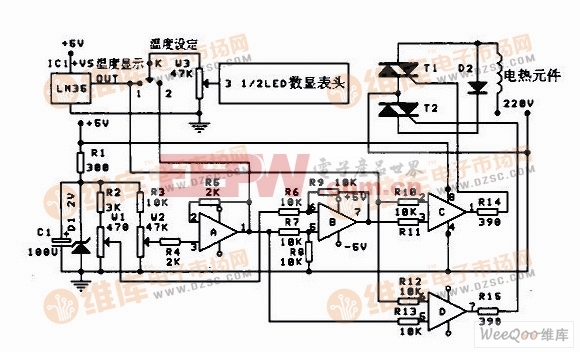

從最近一次網絡攻擊中完全恢復所需的時間

(無具體數據占比)

1 天內

2-7 天

8-15 天

16-30 天

超過 30 天

錯誤仍然令人沮喪地普遍存在。文檔處理平臺提供商 Parseur Pte. Ltd. 上月對 500 名美國高管進行的調查發現,盡管 88% 的受訪者表示對其分析和人工智能系統所依賴數據的準確性非常有信心或比較有信心,但同樣有 88% 的受訪者表示至少有時會發現源自文檔的數據存在錯誤,69% 的受訪者表示錯誤經常或非常頻繁地發生。

智能體網絡會呈指數級放大錯誤。“一個上游數據問題會引發連鎖故障,”Countly 公司的索納說,“如果沒有清晰的數據溯源和完整性保障,就無法判斷是模型出錯、數據出錯,還是系統狀態本身不一致。”

更多關于數據韌性與人工智能的內容:

企業必須將數據韌性視為核心人工智能服務層。

人工智能驅動的預測分析可保護企業存儲免受日益嚴重的安全威脅。

人工智能驅動的自動化和托管檢測服務如何改變網絡韌性。

攻擊終將發生;最佳策略是保護備份,并通過評估指導數據韌性改進。

有多種方法可以審計模型性能以防范異常,但需要檢查輸入數據并跟蹤模型的推理過程。丟失或受損的數據會使此類故障排除工作無法進行。

“技術棧深處某個庫的變更可能毫無影響,也可能導致你突然得到完全不同的答案,盡管表面上看起來沒有任何變化,” 第一資本金融公司(Capital One Financial Corp.)機器學習工程副總裁米里亞姆?弗里德爾(Miriam Friedel)說。她表示,可觀測性、日志記錄和自動掃描支持診斷此類問題所需的取證分析。

數據過載

人工智能還帶來了新的數據類別。訓練數據為復雜模型提供了學習所需的現實世界背景,通常是非結構化的,且體量龐大,使得分類和傳統數據保護措施難以實施。企業很容易對訓練數據采取 “全盤納入” 的策略,將所有數據加載到模型中,讓模型自行整理。

第一資本金融公司弗里德爾:即使 “表面上看起來沒有任何變化”,你也可能得到 “完全不同的答案”。

但這可能會引發網絡安全災難。“如果你有一個數據庫,你知道其中包含什么數據;如果你有一個企業資源規劃(ERP)應用,你知道它只會獲取與其相關的數據,”IDC 的納德卡尼說,“而人工智能會導致企業內部和外部的數據蔓延。人們往往沒有完全意識到這種蔓延的規模,也不清楚可能有哪些惡意行為者試圖破壞數據。”

提示詞和推理數據需要記錄在上下文日志中,這些日志會記錄模型做出決策時所依據的信息。在涉及安全、問責制和可恢復性的場景中,這些記錄至關重要。

推理數據是模型用于做出決策的數據,其獨特挑戰在于,在第三方或云環境中使用時難以對其進行保護。推理數據至關重要,因為它為持續訓練提供支持、可能向外暴露,并且可能觸發自動化工作流。盡管存在這些風險,許多企業仍不愿費心對推理數據進行分類,導致其難以得到有效保護。

“推理輸出很少被視為一等數據,”Countly 公司的索納說,“一旦觸發操作,就無法重現過程。人工智能生成的數據需要像源數據一樣進行治理,而不應被視為日志或無用數據。”

“人們對生成式數據缺乏重視,因為它是多種輸入數據的匯總,”NetApp Inc. 數據服務高級副總裁兼總經理加根?古拉蒂(Gagan Gulati)說,“原始數據的使用通常有相關規則和法規約束,而生成式數據通常沒有。”

如果生成式數據會憑空消失,那倒不成問題,但它往往會留存下來。如果沒有適當的控制措施,人工智能模型可能會記住之前的交互,并將其納入短期記憶。這種遞歸輸出會放大錯誤并引入新的漏洞。

個人身份信息(PII)問題

例如,用戶在提示詞中包含個人身份信息后,可能會在數天后的響應中看到這些數據。如果沒有適當的防護措施,提示詞數據甚至可能成為模型訓練集的一部分,并以不可預測的方式再次出現。

NetApp 公司古拉蒂:“原始數據的使用通常有相關規則約束,而生成式數據通常沒有。”

人工智能在數據訪問管理方面也帶來了新的挑戰,這是韌性的關鍵組成部分。企業不愿使用生產數據訓練模型,因此會制作副本。“這就產生了數據溯源問題,”NetApp 的古拉蒂說,“數據集離開了安全邊界,但所有相同的保護規則都必須適用。”

身份管理公司 Saviynt Inc. 的現場首席技術官大衛?李(David Lee)表示,智能體在數據分類和訪問控制方面帶來了新的挑戰。權限薄弱、權限過于寬泛和廢棄賬戶都會破壞數據韌性,因為所有人工智能系統最終都通過與人相同的身份架構訪問數據。

他說,企業需要細粒度的授權層,以確保智能體不會訪問其不需要的敏感信息。然而,由于人工智能是一項新興技術,此類控制措施往往尚未到位。

根據 Saviynt 近期發布的《人工智能風險報告》,在 235 名安全領導者中,71% 的人表示人工智能工具已經在訪問核心運營系統,但僅有 16% 的人認為他們對這種訪問的治理是有效的。超過 90% 的人表示,他們無法完全掌握人工智能身份,也無法檢測或遏制可能發生的濫用行為。

“復雜之處在于,當存在委托模型(即人工智能智能體調用擁有自身權限的子智能體)時,” 李說,“幾乎不可能看清各個部分之間的關聯、已設置的權限以及誰在授予何種訪問權限。”

智能體通過整合多個來源生成新型數據的能力,給數據分類帶來了問題 —— 而數據分類是訪問管理的必要組成部分。

“假設我有被歸類為機密的數據,還有其他被歸類為個人身份信息的數據,” 李說,“我的智能體將這些數據整合在一起生成了一份報告。現在產生了新的數據,該如何對其進行分類?”

數據分類是一項緩慢而艱巨的任務,許多企業多年前就已放棄或簡化了這一工作,但李認為這種規范正重新受到重視。“我們需要一種三層方法,圍繞數據本身、有權訪問數據的人員以及他們想要對數據執行的操作來構建,” 他說,“如今的系統并非為此設計。”

為人工智能做好準備

這些因素共同凸顯了企業在將人工智能模型從試點推向生產時,必須將數據韌性置于優先地位。大多數觀點認為,企業還有很長的路要走。CData Software Inc. 近期對軟件提供商和企業中負責人工智能項目的 200 人進行的調查發現,僅有 6% 的人表示其數據基礎設施已完全為人工智能做好準備。

Saviynt 公司李:智能體委托可能導致 “無法看清各個部分之間的關聯”。

“對于許多企業而言,人工智能仍然是一個黑箱,這也是高管們不愿信任它的主要原因,” 軟件交付平臺公司 Digital.ai Software Inc. 的產品總監丹尼爾?舒格魯(Daniel Shugrue)說,“企業在人工智能規模化應用方面遇到的障礙不在于模型,而在于他們不信任為人工智能提供數據、轉換數據并依據數據采取行動的系統。”

數據韌性專家倡導所謂的 “人工智能級可恢復性”,這包括了解使用了哪些數據、模型當時處于何種狀態,以及確保流程可以重現或回滾的信心。

“韌性的一部分是,當出現問題時,你能夠快速理解并追蹤問題所在以及如何修復,” 第一資本金融公司的弗里德爾說。

在人工智能時代確保數據韌性需要新的工具和技能組合:

不可變事件日志:系統事件的永久、防篡改記錄,確保每一項決策和數據變更都可追溯和審計。

版本化架構:提供可隨時間跟蹤的結構化數據定義。

端到端溯源分析:展示數據的來源、轉換方式及其對模型輸出的影響。

可重現管道:支持確定性流程重新執行,以重現模型決策。

影響范圍隔離:控制錯誤輸出或操作的影響,防止故障連鎖反應。

經過測試的回滾程序:記錄在案的方法,可將模型、數據或系統狀態恢復到已知良好狀態,且不中斷業務。

數據留存政策:確保刪除冗余、過時和無關緊要的數據,而非將其歸檔(以免帶來污染風險)。

企業人工智能的成功,最終較少依賴新穎的模型架構,而更多依賴于網絡韌性、數據保護和運營嚴謹性等不起眼的規范。能夠保證其人工智能模型所依賴數據穩健性的企業,將更有能力將智能體系統規模化應用于核心業務流程;而那些無法做到這一點的企業,將仍停留在試點和概念驗證階段。現在投資于具備韌性的數據基礎,是未來獲得可信結果的最清晰路徑。

評論